Содержание

Создание хранилища

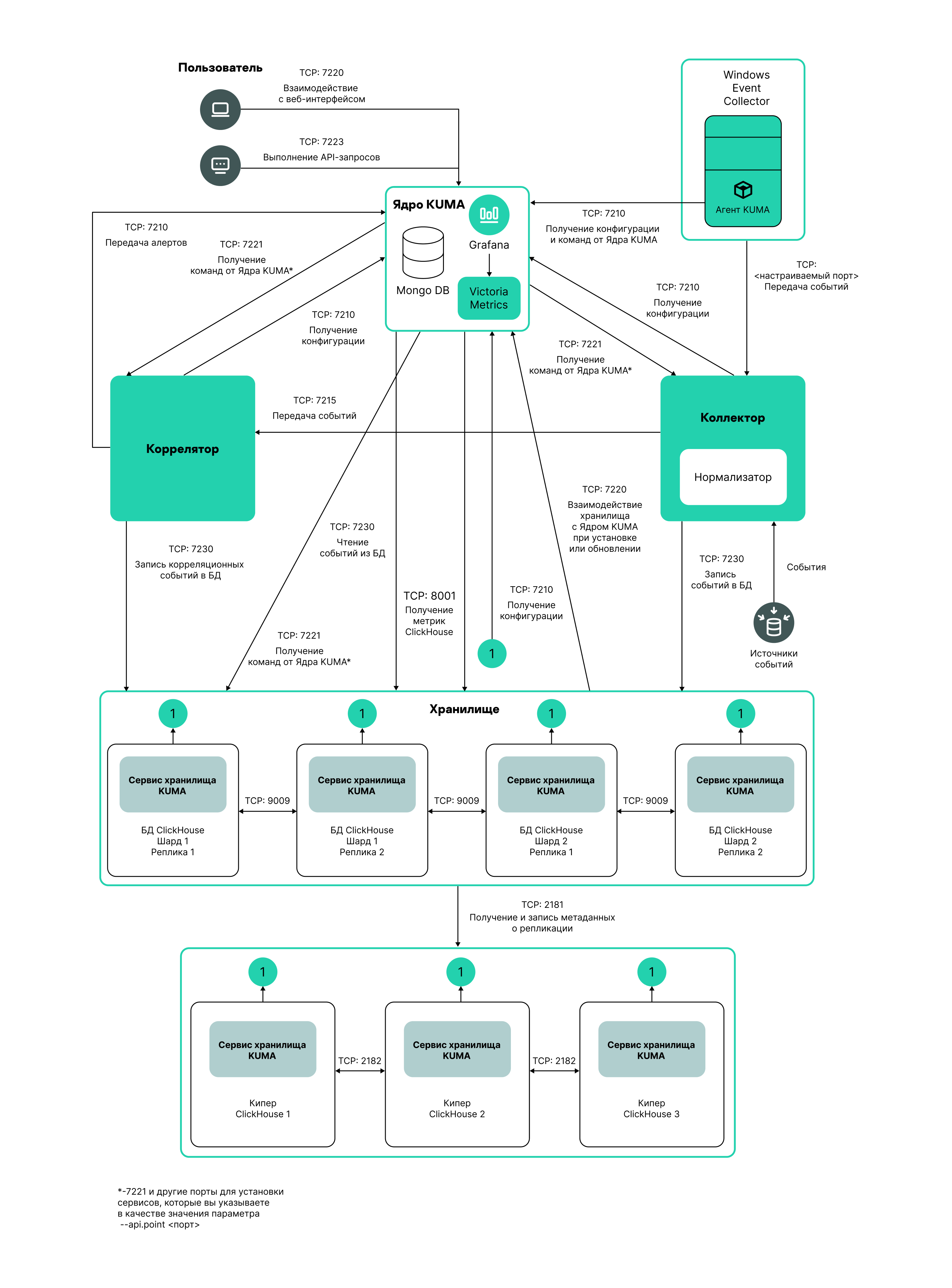

Хранилище состоит из двух частей: одна часть создается внутри веб-интерфейса KUMA, а вторая устанавливается на серверах сетевой инфраструктуры, предназначенных для хранения событий. Серверная часть хранилища KUMA представляет собой собранные в кластер узлы ClickHouse. Кластеры ClickHouse можно дополнять дисками холодного хранения данных.

Для каждого кластера ClickHouse требуется установить отдельное хранилище.

Перед созданием хранилища продумайте структуру кластера и разверните требуемую сетевую инфраструктуру. При выборе конфигурации кластера ClickHouse учитывайте требования вашей организации к хранению событий.

В качестве файловой системы рекомендуется использовать ext4.

Создание хранилища производится в несколько этапов:

- Создание набора ресурсов хранилища в веб-интерфейсе KUMA

- Создание сервиса хранилища в веб-интерфейсе KUMA

- Установка узлов хранилища в сетевой инфраструктуре

При создании узлов кластера хранилища убедитесь в сетевой связности системы и откройте используемые компонентами порты.

При изменении параметров хранилища его сервис необходимо перезапустить.

Структура кластера ClickHouse

Кластер ClickHouse – логическая группа устройств, обладающих всеми накопленными нормализованными событиями KUMA. Подразумевает наличие одного или нескольких логических шардов.

Шард – логическая группа устройств, обладающих некоторой частью всех накопленных в кластере нормализованных событий. Подразумевает наличие одной или нескольких реплик. Увеличение количества шардов позволяет:

- Накапливать больше событий за счет увеличения общего количества серверов и дискового пространства.

- Поглощать больший поток событий за счет распределения нагрузки, связанной со вставкой новых событий.

- Уменьшить время поиска событий за счет распределения поисковых зон между несколькими устройствами.

Реплика – устройство, являющееся членом логического шарда и обладающее одной копией данных этого шарда. Если реплик несколько – копий тоже несколько (данные реплицируются). Увеличение количества реплик позволяет:

- Улучшить отказоустойчивость.

- Распределить общую нагрузку, связанную с поиском данных, между несколькими машинами (однако для этой цели лучше увеличить количество шардов).

Кипер – устройство, участвующее в координации репликации данных на уровне всего кластера. На весь кластер требуется хотя бы одно устройство с этой ролью. Рекомендуемое количество устройств с такой ролью – 3. Число устройств, участвующих в координации репликации, должно быть нечетным. Роль кипера и реплики можно совмещать.

В началоПараметры узлов кластера ClickHouse

Перед созданием хранилища продумайте структуру кластера и разверните требуемую сетевую инфраструктуру. При выборе конфигурации кластера ClickHouse учитывайте требования вашей организации к хранению событий.

При создании узлов кластера ClickHouse убедитесь в сетевой связности системы и откройте используемые компонентами порты.

Для каждого узла кластера ClickHouse требуется указать следующие параметры:

- Полное доменное имя (FQDN) – уникальный адрес, по которому должен быть доступен узел. Необходимо указывать FQDN целиком, например

kuma-storage.example.com. - Идентификаторы шарда, реплики и кипера – комбинация этих параметров определяет положение узла в структуре кластера ClickHouse и его роль.

Роли узлов

Роли узлов зависят от указанных параметров:

- шард, реплика, кипер – узел участвует в накоплении и поиске нормализованных событий KUMA, а также в координации репликации данных на уровне всего кластера.

- шард, реплика – узел участвует в накоплении и поиске нормализованных событий KUMA.

- кипер – узел не накапливает нормализованные события, но участвует в координации репликации данных на уровне всего кластера. Выделенные киперы следует указывать в начале списка в разделе Ресурсы → Хранилища → <Хранилище> → Основные настройки → Узлы кластера ClickHouse.

Требования к идентификаторам:

- Если в одном кластере создано несколько шардов, идентификаторы шардов должны быть уникальными в рамках этого кластера.

- Если в одном шарде создано несколько реплик, идентификаторы реплик должны быть уникальными в рамках этого шарда.

- Идентификаторы киперов должны быть уникальными в рамках кластера.

Пример идентификаторов узлов кластера ClickHouse:

- шард 1, реплика 1, кипер 1;

- шард 1, реплика 2;

- шард 2, реплика 1;

- шард 2, реплика 2, кипер 3;

- шард 2, реплика 3;

- кипер 2.

Холодное хранение событий

В KUMA можно настроить перенос устаревших данных с кластера ClickHouse на холодное хранение. Для холодного хранения могут использоваться смонтированные в операционной системе локальные диски или распределенная файловая система Hadoop Distributed File System (HDFS). Функция холодного хранения включается, если указан хотя бы один диск холодного хранения. Если используется несколько хранилищ,на каждом узле с данными должен быть смонтирован диск холодного хранения или диск HDFS по пути, указанному в конфигурации хранилища. Если диск холодного хранения не настроен и на сервере закончилось место, сервис хранилища остановится. Если есть горячее и холодное хранение и на диске холодного хранения закончилось место, сервис хранилища KUMA остановится. Мы рекомендуем избегать таких ситуаций.

Диски холодного хранения можно добавлять и удалять.

После изменения параметров холодного хранения сервис хранилища необходимо перезапустить. Если сервис не запускается, причина будет указана в журнале хранилища.

Если указанный в параметрах хранилища диск холодного хранения стал недоступен (например, вышел из строя), это может привести к ошибкам в работе сервиса хранилища. В этом случае необходимо воссоздать диск с таким же путем (для локальных дисков) или таким же адресом (для HDFS-дисков), а затем удалить его из параметров хранилища.

Правила переноса данных на диски холодного хранения

При задействованном холодном хранении KUMA раз в час проверяет сроки хранения пространств:

- Если срок хранения пространства на кластере ClickHouse истек, данные переносятся на диски холодного хранения. Если диск холодного хранения настроен неверно, данные удаляются.

- Если срок хранения пространства на диске холодного хранения истек, данные удаляются.

- Если диски кластера ClickHouse заполнены на 95%, самые большие партиции автоматически переносятся на диски холодного хранения. Это действие может происходить больше одного раза в час.

- При начале и окончании переноса данных создаются события аудита.

Во время переноса данных сервис хранилища продолжает работать, при этом в разделе веб-интерфейса KUMA Ресурсы → Активные сервисы для него сохраняется зеленый статус. При наведении указателя мыши на значок статуса отображается сообщение о переносе данных. При удалении холодного диска сервис хранилища отображается в желтом статусе.

Особенности хранения событий и доступа к ним

- При использовании для холодного хранения HDFS-дисков необходимо обеспечить защиту данных одним из следующих способов:

- Настроить отдельный физический интерфейс в сети VLAN, в котором будут расположены только HDFS-диски и кластер ClickHouse.

- Настроить правила сегментации сети и фильтрации трафика, исключающие прямой доступ к HDFS-диску или перехват трафика к диску со стороны ClickHouse.

- События, находящиеся в кластере ClickHouse и на дисках холодного хранения, одинаково доступны в веб-интерфейсе KUMA. Например, при поиске событий или при просмотре событий, относящихся к алертам.

- Допускается не хранить события или события аудита на дисках холодного хранения: для этого в параметрах хранилища в поле Срок холодного хранения или Срок холодного хранения событий аудита необходимо указать

0(дней).

Особенности использования HDFS-дисков

- Перед подключением HDFS-дисков на них необходимо создать директории для каждого узла кластера ClickHouse в формате

<хост HDFS-диска>/<идентифика тор шарда>/<идентификатор реплики>. Например, если кластер состоит из двух узлов, на которых расположены две реплики одного шарда, необходимо создать следующие директории:- hdfs://hdfs-example-1:9000/clickhouse/1/1/

- hdfs://hdfs-example-1:9000/clickhouse/1/2/

События из узлов кластера ClickHouse будут переноситься в директории, в названии которых указаны идентификаторы их шарда и реплики. Если изменить эти параметры узла и при этом не создать соответствующую директорию на HDFS-диске, события при переносе могут быть потеряны.

- HDFS-диски, добавленные к хранилищу, работают в режиме JBOD. Это означает, что при отказе одного из дисков будет потерян доступ к хранилищу. При использовании HDFS следует учитывать необходимость отказоустойчивости и настроить RAID, а также хранение данных из разных реплик на различных устройствах.

- Скорость записи событий в HDFS, как правило, ниже скорости записи событий на локальные диски. Скорость доступа к событиям в HDFS, как правило, значительно ниже скорости доступа к событиям на локальных дисках. При использовании одновременно локальных дисков и HDFS-дисков запись будет происходить в них по очереди.

Удаление дисков холодного хранения

Перед физическим отключением дисков холодного хранения необходимо удалить эти диски из параметров хранилища.

Чтобы удалить диск из параметров хранилища:

- В веб-интерфейсе KUMA перейдите в раздел Ресурсы → Хранилища и выберите нужное хранилище.

Откроется хранилище.

- В окне в разделе Диски холодного хранения в блоке параметров нужного диска нажмите Удалить диск.

Данные с удаляемого диска автоматически начинают переноситься на другие диски холодного хранения или, если их нет, в кластер ClickHouse. В процессе переноса данных значок статуса хранилища светится желтым цветом и отображается значок песочных часов. При начале и окончании переноса данных создаются события аудита.

- По завершении переноса событий диск автоматически удаляется из параметров хранилища. Теперь его можно безопасно отключить.

На удаляемых дисках могут оставаться события. Если вы хотите их удалить, вы можете, например, вручную удалить партиции с данными с помощью команды DROP PARTITION.

Если указанный в параметрах хранилища диск холодного хранения стал недоступен (например, вышел из строя), это может привести к ошибкам в работе сервиса хранилища. В этом случае необходимо создать диск с таким же путем (для локальных дисков) или таким же адресом (для HDFS-дисков), а затем удалить его из параметров хранилища.

В началоОтключение, архивирование и подключение партиций

Если вы хотите оптимизировать дисковое пространство и ускорить выполнение запросов в KUMA, вы можете отключить в ClickHouse партиции с данными, архивировать партиции или перенести их на носитель. При необходимости вы можете снова подключить необходимые партиции и выполнить обработку данных.

Отключение партиций

Чтобы отключить партиции, выполните следующие шаги:

- Определите шард, на всех репликах которого вы планируете отключить партицию.

- Получите идентификатор партиции с помощью следующей команды:

sudo /opt/kaspersky/kuma/clickhouse/bin/client.sh -d kuma --multiline --query "SELECT partition, name FROM system.parts;" |grep 20231130В приведенном примере в результате выполнения команды будет получен идентификатор партиции от 30 ноября 2023 года.

- На каждой реплике шарда отключите партицию с помощью следующей команды, указав требуемый идентификатор:

sudo /opt/kaspersky/kuma/clickhouse/bin/client.sh -d kuma --multiline --query "ALTER TABLE events_local_v2 DETACH PARTITION ID '<идентификатор партиции>'"

В результате партиция отключена на всех репликах шарда. Теперь вы можете перенести каталог с данными на носитель или заархивировать партицию.

Архивирование партиций

Чтобы архивировать отключенные партиции:

- Найдите отключенную партицию в дисковой подсистеме сервера:

sudo find /opt/kaspersky/kuma/clickhouse/data/ -name <идентификатор отключенной партиции>\* Перейдите в каталог detached с отключенной партицией и, находясь в каталоге detached, выполните архивирование:sudo cd <путь к каталогу detached, содержащему отключенную партицию>sudo zip -9 -r detached.zip *Например:

sudo cd /opt/kaspersky/kuma/clickhouse/data/store/d5b/d5bdd8d8-e1eb-4968-95bd-d8d8e1eb3968/detached/sudo zip -9 -r detached.zip *

Архивирование партиции выполнено.

Подключение партиций

Чтобы подключить архивные партиции к KUMA, необходимо выполнить следующие действия:

- Увеличьте значение параметра Срок хранения.

KUMA удаляет данные на основании даты, указанной в поле Timestamp - когда событие получено, и на основании значения параметра Срок хранения, которое вы задали для хранилища.

Перед тем как выполнять восстановление архивных данных, убедитесь, что значение параметра Срок хранения перекрывает дату из поля Timestamp. В противном случае, архивные данные будут удалены в течение 1 часа.

- Поместите архивную партицию в раздел detached вашего хранилища и распакуйте архив:

sudounzip detached.zip -d<путь к каталогу detached>Например:

sudounzip detached.zip -d/opt/kaspersky/kuma/clickhouse/data/store/d5b/d5bdd8d8-e1eb-4968-95bd-d8d8e1eb3968/detached/ - Выполните команду подключения партиции:

sudo /opt/kaspersky/kuma/clickhouse/bin/client.sh -d kuma --multiline --query "ALTER TABLE events_local_v2 ATTACH PARTITION ID '<идентификатор партиции>'"Повторите шаги распаковки архива и подключения партиции на каждой реплике шарда.

В результате архивная партиция подключена и события снова доступны для поиска.

В началоСоздание набора ресурсов для хранилища

Сервис хранилища в веб-интерфейсе KUMA создается на основе набора ресурсов для хранилища.

Чтобы создать набор ресурсов для хранилища в веб-интерфейсе KUMA:

- В веб-интерфейсе KUMA в разделе Ресурсы → Хранилища нажмите Добавить хранилище.

Откроется окно Создание хранилища.

- На вкладке Основные параметры в поле Название хранилища введите уникальное имя создаваемого сервиса. Название должно содержать от 1 до 128 символов в кодировке Unicode.

- В раскрывающемся списке Тенант выберите тенант, которому будет принадлежать хранилище.

- В поле Описание можно добавить описание сервиса: до 256 символов в кодировке Unicode.

- В поле Срок хранения укажите, в течение какого количества дней с момента поступления вы хотите хранить события в кластере ClickHouse. По истечении указанного срока события будут автоматически удалены из кластера ClickHouse. Если настроено холодное хранение событий и срок хранения событий в кластере ClickHouse истек, данные переносятся на диски холодного хранения. Если диск холодного хранения настроен неверно, данные удаляются.

- В поле Срок хранения событий аудита укажите, в течение какого количества дней вы хотите хранить события аудита. Минимальное значение и значение по умолчанию:

365. - При необходимости холодного хранения данных введите сроки хранения событий:

- Срок холодного хранения – количество дней хранения событий. Минимальное значение –

1. - Срок холодного хранения событий аудита – количество дней хранения событий аудита. Минимальное значение – 0.

- Срок холодного хранения – количество дней хранения событий. Минимальное значение –

- С помощью переключателя Отладка укажите, будет ли включено логирование ресурса. Значение по умолчанию: Выключено - это означает, что для всех компонентов KUMA в журнале регистрируются только ошибки. Если вы хотите получать детализированные данные в журналах, выберите значение Включено.

- При необходимости изменения параметров ClickHouse в поле Переопределение параметров ClickHouse вставьте строки c параметрами из XML-файла конфигурации ClickHouse /opt/kaspersky/kuma/clickhouse/cfg/config.xml. Указание корневых элементов <yandex>, </yandex> не требуется. Переданные в поле параметры конфигурации будут использоваться вместо параметров по умолчанию.

Пример:

<merge_tree>

<parts_to_delay_insert>600</parts_to_delay_insert>

<parts_to_throw_insert>1100</parts_to_throw_insert>

</merge_tree>

- При необходимости в разделе Пространства добавьте в хранилище пространства, по которым вы хотите распределять хранимые события.

Пространств может быть несколько. Пространства можно добавить с помощью кнопки Добавить пространство и удалить с помощью кнопки Удалить пространство.

Доступные параметры:

- В поле Название укажите название пространства: от 1 до 128 символов в кодировке Unicode.

- В поле Срок хранения укажите количество дней, в течение которых события будут храниться в кластере ClickHouse.

- При необходимости в поле Срок холодного хранения укажите количество дней, в течение которого события должны находиться на холодном хранении. Минимальное значение –

1. - В разделе Фильтр можно задать условия определения событий, которые будут помещаться в это пространство. В раскрывающемся списке можно выбрать существующий фильтр или Создать новый фильтр.

После создания сервиса пространства можно просматривать и удалять в параметрах набора ресурсов хранилища.

Нет необходимости создавать отдельное пространство для событий аудита. События этого типа (Type=4) автоматически помещаются в отдельное пространство Audit со сроком хранения не менее 365 дней, которое недоступно для редактирования или удаления из веб-интерфейса KUMA.

- При необходимости в разделе Диски холодного хранения добавьте в хранилище диски, на которые вы хотите переносить события на длительное хранение из кластера ClickHouse.

Дисков может быть несколько. Диски можно добавить с помощью кнопки Добавить диск и удалить с помощью кнопки Удалить диск.

Доступные параметры:

- В раскрывающемся списке Тип выберите тип подключаемого диска:

- Локальный – для дисков, смонтированных в операционной системе как директории.

- HDFS – для дисков распределенной файловой системы Hadoop Distributed File System.

- В поле Название укажите название диска. Название должно содержать от 1 до 128 символов в кодировке Unicode.

- Если в качестве типа диска вы выбрали Локальный, в поле Путь введите абсолютный путь директории смонтированного локального диска. Путь должен начинаться и оканчиваться символом "/".

- Если в качестве типа диска вы выбрали HDFS, в поле Хост введите путь к HDFS. Например:

hdfs://hdfs1:9000/clickhouse/.

- В раскрывающемся списке Тип выберите тип подключаемого диска:

- При необходимости в разделе Узлы кластера ClickHouse добавьте в хранилище узлы кластера ClickHouse.

Узлов может быть несколько. Узлы можно добавить с помощью кнопки Добавить узел и удалить с помощью кнопки Удалить узел.

Доступные параметры:

- В поле Полное доменное имя укажите FQDN добавляемого узла. Например,

kuma-storage-cluster1-server1.example.com. - В полях идентификаторов шарда, реплики и кипера укажите роль узла в кластере ClickHouse. Идентификаторы шарда и кипера должны быть уникальными в рамках кластера, идентификатор реплики должен быть уникальным в рамках шарда. Ниже показан пример заполнения раздела Узлы кластера ClickHouse для хранилища с выделенными киперами в распределенной схеме установки. Вы можете адаптировать пример для своих потребностей.

Пример:

Узлы кластера ClickHouse

Полное доменное имя: kuma-storage-cluster1-server1.example.com

Идентификатор шарда: 0

Идентификатор реплики: 0

Идентификатор кипера: 1

Полное доменное имя: kuma-storage-cluster1server2.example.com

Идентификатор шарда: 0

Идентификатор реплики: 0

Идентификатор кипера: 2

Полное доменное имя: kuma-storage-cluster1server3.example.com

Идентификатор шарда: 0

Идентификатор реплики: 0

Идентификатор кипера: 3

Полное доменное имя: kuma-storage-cluster1server4.example.com

Идентификатор шарда: 1

Идентификатор реплики: 1

Идентификатор кипера: 0

Полное доменное имя: kuma-storage-cluster1server5.example.com

Идентификатор шарда: 1

Идентификатор реплики: 2

Идентификатор кипера: 0

Полное доменное имя: kuma-storage-cluster1server6.example.com

Идентификатор шарда: 2

Идентификатор реплики: 1

Идентификатор кипера: 0

Полное доменное имя: kuma-storage-cluster1server7.example.com

Идентификатор шарда: 2

Идентификатор реплики: 2

Идентификатор кипера: 0

- В поле Полное доменное имя укажите FQDN добавляемого узла. Например,

- Начиная с версии 2.1.3 доступна вкладка Дополнительные параметры. На вкладке Дополнительные параметры в поле Размер буфера укажите размер буфера в байтах, при достижении которого следует передать события в базу. Значение по умолчанию — 64 МБ. Максимального значения нет. Если на виртуальной машине меньше свободной памяти, чем заданное значение Размер буфера, KUMA установит ограничение в 128 МБ.

- На вкладке Дополнительные параметры в поле Интервал очистки буфера укажите интервал в секундах, в течение которого KUMA будет ждать заполнения буфера. Если буфер не заполнен, но указанное время прошло, KUMA передает события в базу. Значение по умолчанию 1 с.

- На вкладке Дополнительные параметры в поле Размер дискового буфера укажите значение в байтах. Дисковый буфер используется для временного размещения тех событий, которые не удалось отправить для дальнейшей обработки или хранения. Если выделенное под дисковый буфер дисковое пространство исчерпано, события ротируются по следующему правилу: новые события замещают самые старые события, записанные в буфер. Значение по умолчанию: 10 ГБ.

- На вкладке Дополнительные параметры в раскрывающемся списке Дисковый буфер выберите значение, с помощью которого можно Включить или Выключить использование дискового буфера. По умолчанию дисковый буфер включен.

- На вкладке Дополнительные параметры в раскрывающемся списке Запись в локальную таблицу базы данных выберите значение, с помощью которого можно Включить или Выключить запись. По умолчанию запись отключена.

В режиме Включить запись будет выполняться только на том узле, на котором установлено хранилище. Мы рекомендуем использовать эту функцию только при условии, что у вас настроена балансировка на коллекторе и/или корреляторе: в коллекторе и/или корреляторе на шаге 6. Маршрутизация в разделе Дополнительные настройки в поле Политика выбора URL установлено значение По очереди.

В режиме Выключить данные распределяются по шардам кластера.

Набор ресурсов для хранилища создан и отображается в разделе Ресурсы → Хранилища. Теперь можно создать сервис хранилища.

В началоСоздание сервиса хранилища в веб-интерфейсе KUMA

Когда набор ресурсов для хранилища создан, можно перейти к созданию сервиса хранилища в KUMA.

Чтобы создать сервис хранилища в веб-интерфейсе KUMA:

- В веб-интерфейсе KUMA в разделе Ресурсы → Активные сервисы нажмите Добавить сервис.

- В открывшемся окне Выберите сервис выберите только что созданный набор ресурсов для хранилища и нажмите Создать сервис.

Сервис хранилища создан в веб-интерфейсе KUMA и отображается в разделе Ресурсы → Активные сервисы. Теперь сервисы хранилища необходимо установить на каждом узле кластера ClickHouse, используя идентификатор сервиса.

В началоУстановка хранилища в сетевой инфраструктуре KUMA

Чтобы создать хранилище:

- Войдите на сервер, на котором вы хотите установить сервис.

- Выполните следующую команду:

sudo /opt/kaspersky/kuma/kuma storage --core https://<FQDN сервера Ядра KUMA>:<порт, используемый Ядром KUMA для внутренних коммуникаций (по умолчанию используется порт 7210)> --id <идентификатор сервиса, скопированный из веб-интерфейса KUMA> --installПример:

sudo /opt/kaspersky/kuma/kuma storage --core https://kuma.example.com:7210 --id XXXXX --installПри развертывании нескольких сервисов KUMA на одном хосте в процессе установки необходимо указать уникальные порты для каждого компонента с помощью параметра

--api.port <порт>. По умолчанию используется значение--api.port 7221. - Повторите шаги 1–2 для каждого узла хранилища.

На одном хосте может быть установлен только один сервис хранилища.

Хранилище установлено.

В начало .

.