Установка и удаление KUMA

Развернуть всё | Свернуть всё

Для выполнения установки вам понадобится дистрибутив:

- kuma-ansible-installer-<номер сборки>.tar.gz содержит все необходимые файлы для установки KUMA без поддержки отказоустойчивых конфигураций.

- kuma-ansible-installer-ha-<номер сборки>.tar.gz содержит все необходимые файлы для установки KUMA в отказоустойчивой конфигурации.

Для установки вам понадобится файл установщика install.sh и файл инвентаря с описанием инфраструктуры. Файл инвентаря вы сможете создать на основе шаблона. Каждый дистрибутив содержит файл установщика install.sh и следующие шаблоны файла инвентаря:

- single.inventory.yml.template

- distributed.inventory.yml.template

- expand.inventory.yml.template

- k0s.inventory.yml.template

KUMA размещает свои файлы в папке /opt, поэтому мы рекомендуем сделать /opt отдельным разделом и выделить под него все дисковое пространство, за исключением 16 ГБ для операционной системы.

Установка KUMA выполняется одинаково на всех хостах при помощи установщика и подготовленного вами файла инвентаря, в котором описана конфигурация. Мы рекомендуем заранее продумать схему установки.

Доступны следующие варианты установки:

- Установка на одном сервере

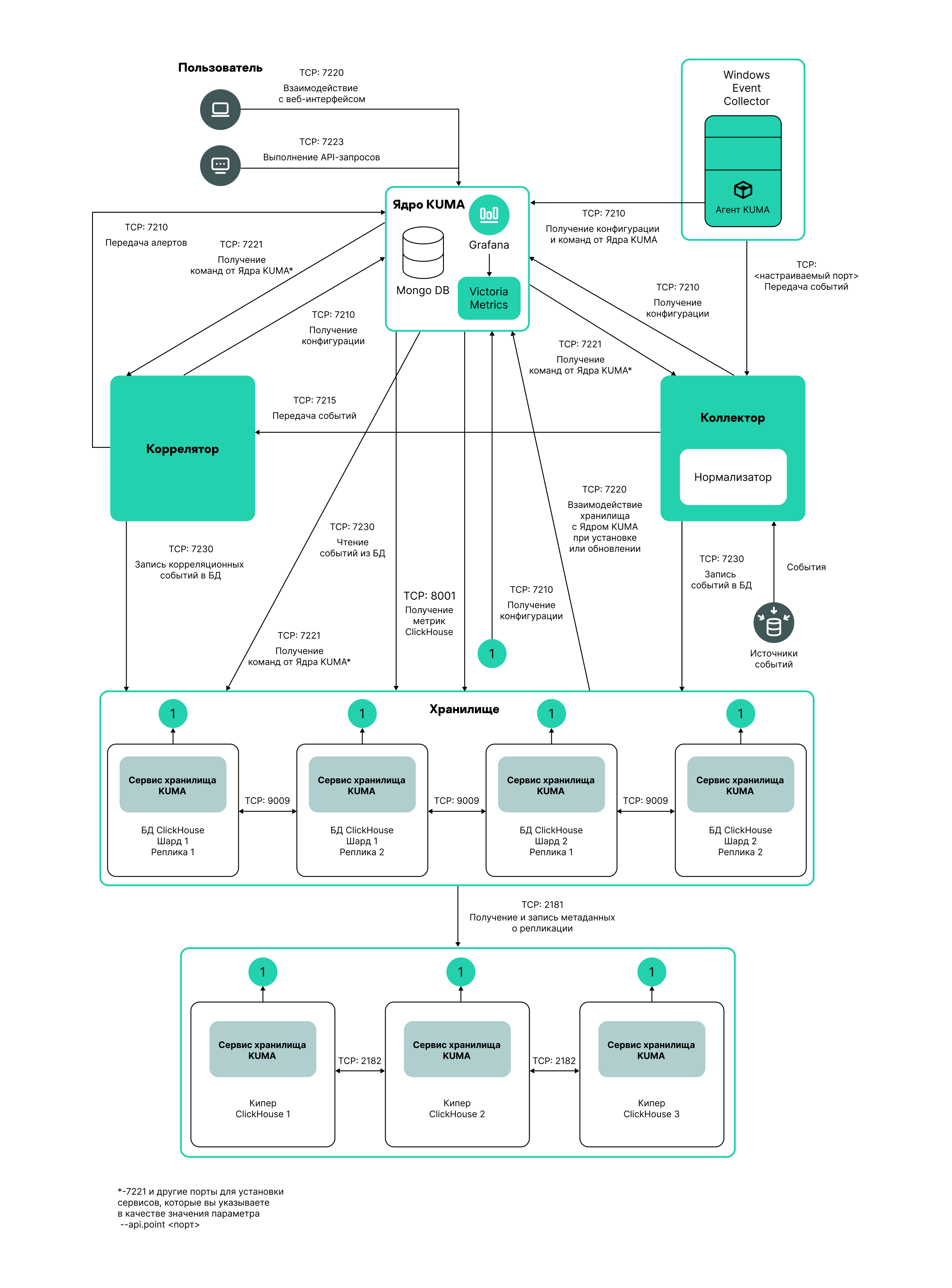

Схема установки на одном сервере

Установка на одном сервере

Пример файла инвентаря для схемы установки на одном сервере

all:

vars:

deploy_to_k8s: false

need_transfer: false

generate_etc_hosts: false

deploy_example_services: true

no_firewall_actions: false

kuma:

vars:

ansible_connection: ssh

ansible_user: root

children:

kuma_core:

hosts:

kuma1.example.com:

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma1.example.com

kuma_correlator:

hosts:

kuma1.example.com

kuma_storage:

hosts:

kuma1.example.com:

shard: 1

replica: 1

keeper: 1

Вы можете установить все компоненты KUMA на одном сервере: в файле инвентаря single.inventory.yml для всех компонентов следует указывать один сервер. Установка "все в одном" может обеспечить обработку небольшого потока событий - до 10000 EPS. Если вы планируете использовать много макетов панели мониторинга и обрабатывать большой объем поисковых запросов, одного сервера может не хватить. Мы рекомендуем выбрать распределенную установку.

- Распределенная установка

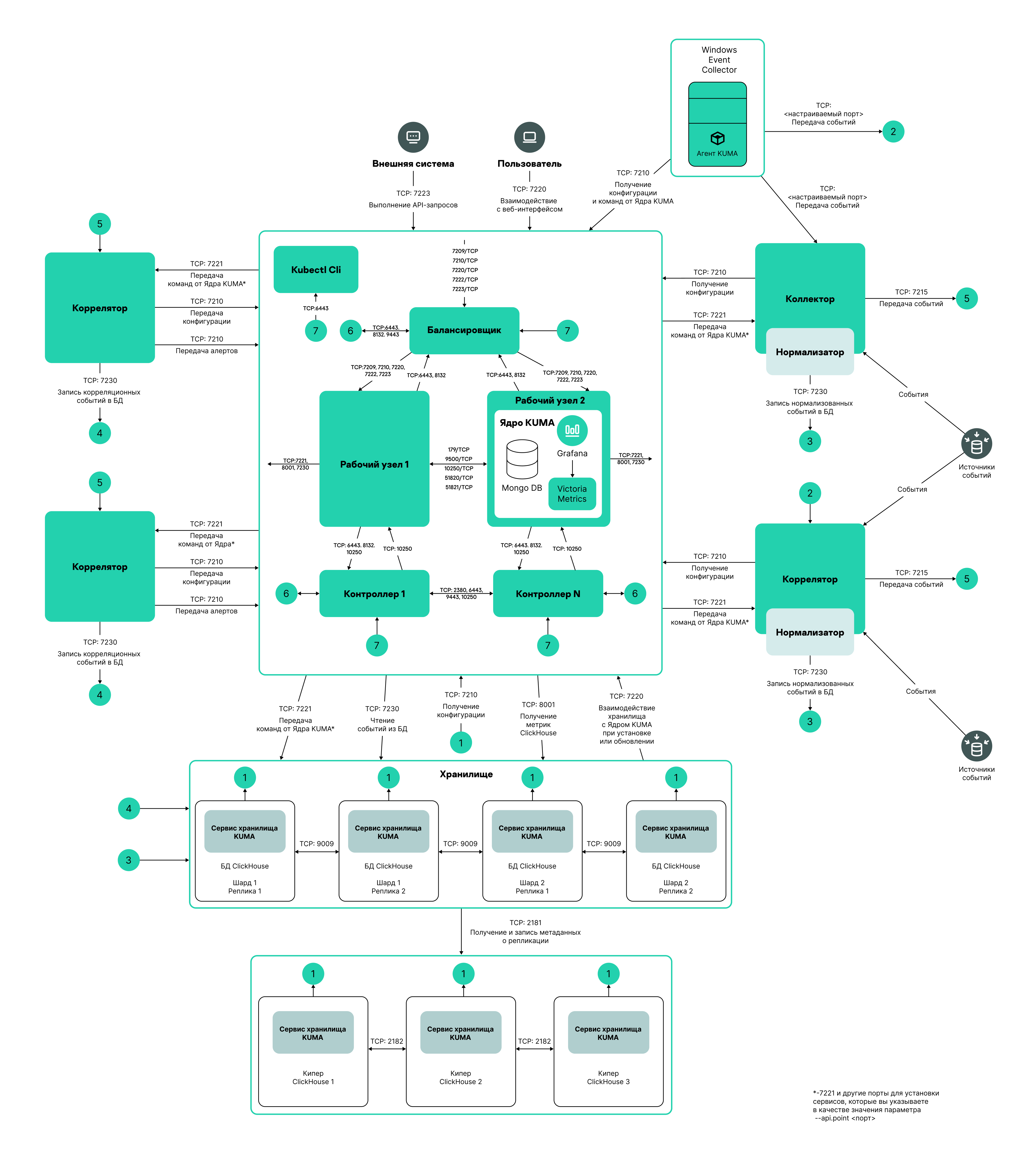

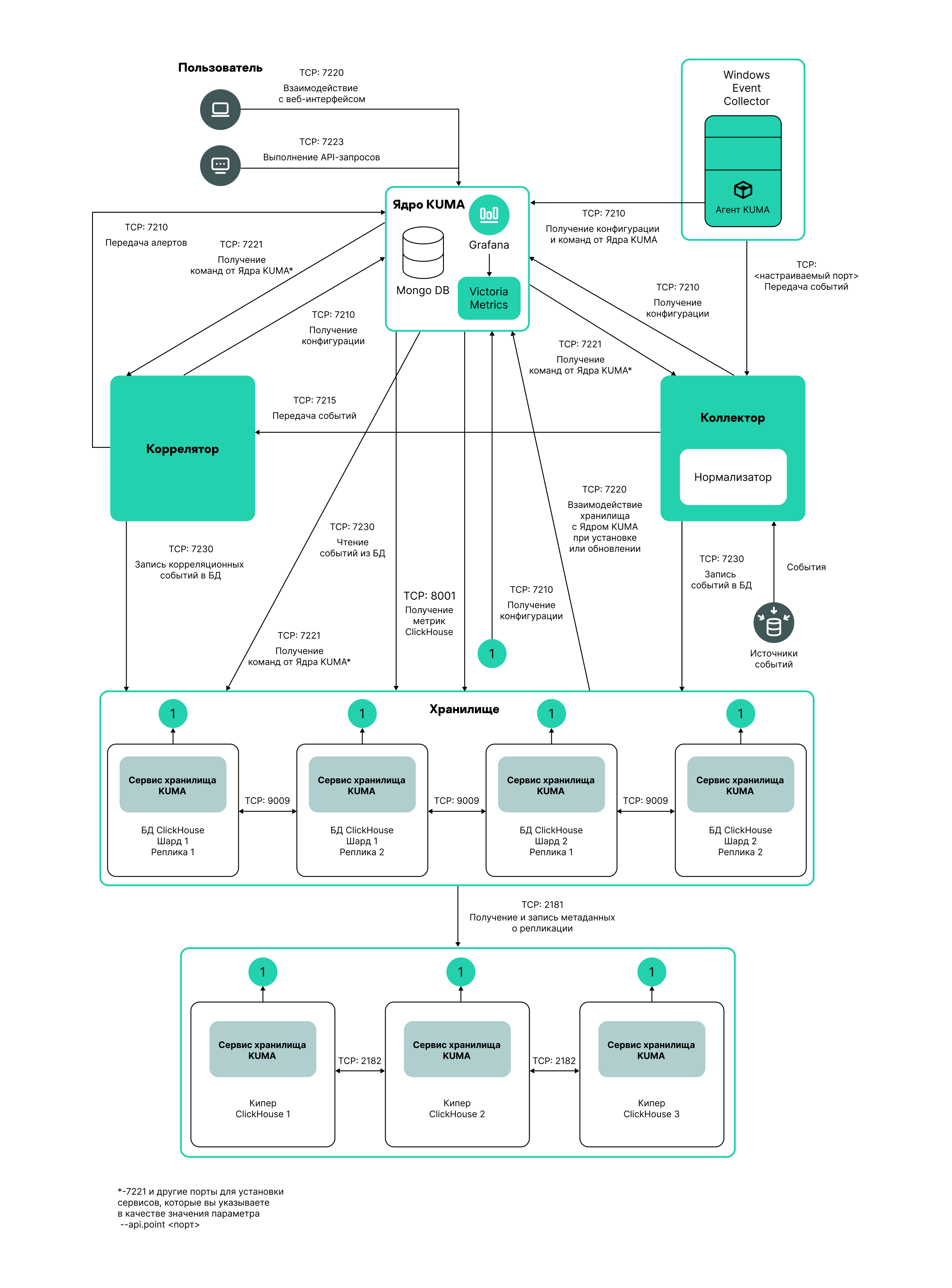

Схема распределенной установки

Схема распределенной установки

Пример файла инвентаря для схемы распределенной установки

all:

vars:

deploy_to_k8s: false

need_transfer: false

generate_etc_hosts: false

deploy_example_services: false

no_firewall_actions: false

kuma:

vars:

ansible_connection: ssh

ansible_user: root

children:

kuma_core:

hosts:

kuma-core-1.example.com:

ip: 0.0.0.0

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma-collector-1.example.com:

ip: 0.0.0.0

kuma_correlator:

hosts:

kuma-correlator-1.example.com:

ip: 0.0.0.0

kuma_storage:

hosts:

kuma-storage-cluster1-server1.example.com:

ip: 0.0.0.0

shard: 1

replica: 1

keeper: 0

kuma-storage-cluster1-server2.example.com:

ip: 0.0.0.0

shard: 1

replica: 2

keeper: 0

kuma-storage-cluster1-server3.example.com:

ip: 0.0.0.0

shard: 2

replica: 1

keeper: 0

kuma-storage-cluster1-server4.example.com:

ip: 0.0.0.0

shard: 2

replica: 2

keeper: 0

kuma-storage-cluster1-server5.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 1

kuma-storage-cluster1-server6.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 2

kuma-storage-cluster1-server7.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 3

Вы можете установить сервисы KUMA на разных серверах: конфигурацию для распределенной установки вы можете описать в файле инвентаря distributed.inventory.yml.

- Распределенная установка в отказоустойчивой конфигурации

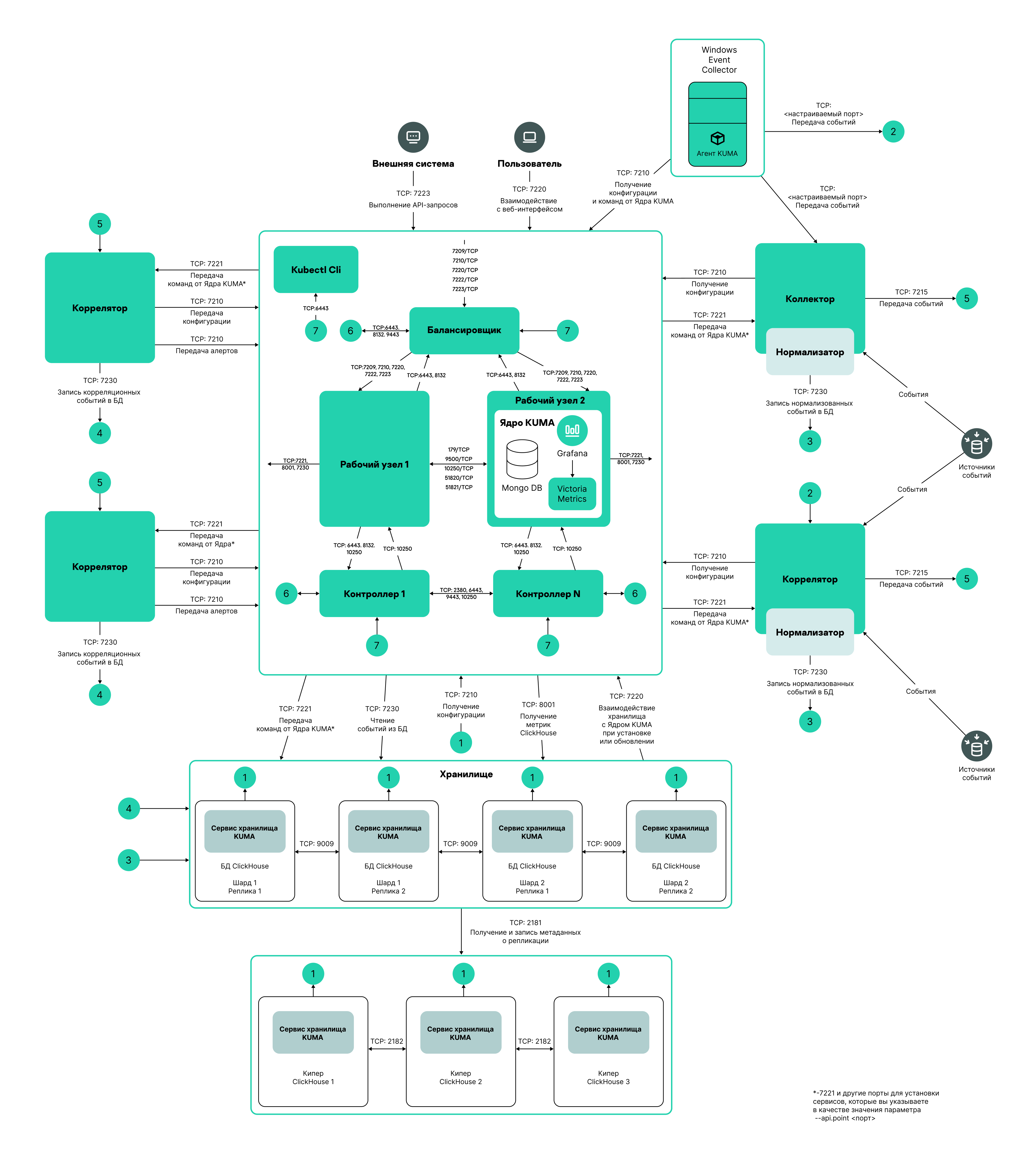

Схема распределенной установки в отказоустойчивой конфигурации

Распределенная установка в отказоустойчивой конфигурации

Пример файла инвентаря для схемы распределенной установки в отказоустойчивой конфигурации

all:

vars:

deploy_to_k8s: true

need_transfer: true

generate_etc_hosts: false

airgap: true

deploy_example_services: false

no_firewall_actions: false

kuma:

vars:

ansible_connection: ssh

ansible_user: root

children:

kuma_core:

hosts:

kuma-core-1.example.com:

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma-collector-1.example.com:

ip: 0.0.0.0

kuma-collector-2.example.com:

ip: 0.0.0.0

kuma_correlator:

hosts:

kuma-correlator-1.example.com:

ip: 0.0.0.0

kuma-correlator-2.example.com:

ip: 0.0.0.0

kuma_storage:

hosts:

kuma-storage-cluster1-server1.example.com:

ip: 0.0.0.0

shard: 1

replica: 1

keeper: 0

kuma-storage-cluster1-server2.example.com:

ip: 0.0.0.0

shard: 1

replica: 2

keeper: 0

kuma-storage-cluster1-server3.example.com:

ip: 0.0.0.0

shard: 2

replica: 1

keeper: 0

kuma-storage-cluster1-server4.example.com:

ip: 0.0.0.0

shard: 2

replica: 2

keeper: 0

kuma-storage-cluster1-server5.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 1

kuma-storage-cluster1-server6.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 2

kuma-storage-cluster1-server7.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 3

kuma_k0s:

vars:

ansible_connection: ssh

ansible_user: root

children:

kuma_lb:

hosts:

kuma_lb.example.com:

kuma_managed_lb: true

kuma_control_plane_master:

hosts:

kuma_cpm.example.com:

ansible_host: 10.0.1.10

kuma_control_plane_master_worker:

kuma_control_plane:

hosts:

kuma_cp1.example.com:

ansible_host: 10.0.1.11

kuma_cp2.example.com:

ansible_host: 10.0.1.12

kuma_control_plane_worker:

kuma_worker:

hosts:

kuma-core-1.example.com:

ansible_host: 10.0.1.13

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

kuma_worker2.example.com:

ansible_host: 10.0.1.14

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

Вы можете установить Ядро KUMA в кластере Kubernetes для обеспечения отказоустойчивости. Используйте файл инвентаря k0s.inventory.yml для описания конфигурации.

В начало

[Topic 217904]

Требования к установке программы

Общие требования к установке программы

Вы можете установить программу на следующих операционных системах:

- Oracle Linux.

- Astra Linux.

- Ubuntu 22.04 LTS.

- РЕД ОС 7.3.4 или 8.

Поддерживаются конфигурации Сервер и Сервер с поддержкой графического интерфейса. В конфигурации Сервер с поддержкой графического интерфейса не требуется устанавливать дополнительные пакеты для формирования отчетов.

Операционная система РЕД ОС 8 поддерживается без высокой доступности (англ. High Availability, HA). При использовании операционной системы РЕД ОС 8 в конфигурации Сервер с поддержкой графического интерфейса вам нужно установить пакет iscsi-initiator-utils, после чего выполнить следующие команды:

systemctl enable iscsid

systemctl start iscsid

Перед развертыванием программы убедитесь, что выполнены следующие условия:

- Серверы, предназначенные для установки компонентов, соответствуют аппаратным и программным требованиям.

- Порты, которые KUMA займет при установке, доступны.

- Адресация компонентов KUMA осуществляется по полному доменному имени FQDN хоста в формате hostname.example.com. Перед установкой программы убедитесь, что в поле

Static hostname возвращается правильное имя FQDN хоста. Для этого выполните команду:hostnamectl status

- Имя сервера, на котором запускается установщик, отличается от

localhost или localhost.<домен>. - Имя сервера, котором будет установлено Ядро KUMA, не начинается с цифры.

- Настроена синхронизация времени на всех серверах с сервисами KUMA по протоколу Network Time Protocol (NTP).

Требования к установке на операционных системах Oracle Linux, Astra Linux, Ubuntu 22.04 LTS и РЕД ОС 7.3.4 и 8

|

Oracle Linux

|

Astra Linux

|

Ubuntu 22.04 LTS

|

РЕД ОС 7.3.4 и 8

|

Версия Python

|

С 3.6 по 3.11. Версии 3.12 и выше не поддерживаются.

|

С 3.6 по 3.11. Версии 3.12 и выше не поддерживаются.

|

С 3.6 по 3.11. Версии 3.12 и выше не поддерживаются.

|

С 3.6 по 3.11. Версии 3.12 и выше не поддерживаются.

|

Модуль SELinux

|

Выключен.

|

Выключен.

|

Выключен.

|

Выключен.

|

Система управления пакетами

|

pip3.

|

pip3.

|

pip3.

|

pip3.

|

Основные пакеты

|

Подробнее об обновлении с операционной системы Oracle Linux 8.x до Oracle Linux 9.x.

Вы можете установить пакеты с помощью следующих команд:

pip3 install netaddr

yum install firewalld

yum install compat-openssl11

|

- python3-apt.

- curl.

- libcurl4.

Вы можете установить пакеты с помощью команды:

apt install python3-apt curl libcurl4

|

- python3-apt.

- curl.

- libcurl4.

- openssl 1.1.1.

- acl.

Вы можете установить пакеты с помощью команды:

apt install python3-apt curl libcurl4 acl

Вы можете скачать пакет openssl1.1.1 с официального сайта Ubuntu и установить с помощью команды:

dpkg -i libssl1.1_1.1.1f-1ubuntu2_amd64.deb

|

- netaddr.

- firewalld.

- compat-openssl11.

Вам нужно установить этот пакет на хосте с операционной системой РЕД ОС 7.3.4 или 8, где будет разворачиваться Ядро KUMA вне кластера.

- dnf install openssl1.1.

Вам нужно установить этот пакет на операционной системе РЕД ОС 8.

Вы можете установить пакеты с помощью следующих команд:

pip3 install netaddr

dnf install firewalld

dnf install compat-openssl11

|

Зависимые пакеты

|

Нет значения.

|

- netaddr.

- python3-cffi-backend.

Вы можете установить пакеты с помощью команды:

apt install python3-netaddr python3-cffi-backend

Если вы планируете обращаться к базам данных Oracle DB из KUMA, вам нужно установить пакет Astra Linux libaio1.

|

- netaddr.

- python3-cffi-backend.

Вы можете установить пакеты с помощью команды:

apt install python3-netaddr python3-cffi-backend

|

Нет значения.

|

Пакеты, которые нужно установить на устройстве с Ядром KUMA для корректного формирования отчетов и возможности их скачивания

|

- nss.

- gtk2.

- atk.

- libnss3.so.

- libatk-1.0.so.0.

- libxkbcommon.

- libdrm.

- at-spi2-atk.

- mesa-libgbm.

- alsa-lib.

- cups-libs.

- libXcomposite.

- libXdamage.

- libXrandr.

Вы можете установить пакеты с помощью команды:

yum install nss gtk2 atk libnss3.so libatk-1.0.so.0 libxkbcommon libdrm at-spi2-atk mesa-libgbm alsa-lib cups-libs libXcomposite libXdamage libXrandr

|

- libgtk2.0.0.

- libnss3.

- libatk-adaptor.

- libatk-1.0.so.0.

- libdrm-common.

- libgbm1.

- libxkbcommon0.

- libasound2.

Вы можете установить пакеты с помощью команды:

apt install libgtk2.0.0 libnss3 libatk-adaptor libatk-1.0.so.0 libdrm-common libgbm1 libxkbcommon0 libasound2

|

- libatk1.0-0.

- libgtk2.0-0.

- libatk-bridge2.0-0.

- libcups2.

- libxcomposite-dev.

- libxdamage1.

- libxrandr2.

- libgbm-dev.

- libxkbcommon-x11-0.

- libpangocairo-1.0-0.

- libasound2.

Вы можете установить пакеты с помощью команды:

apt install libatk1.0-0 libgtk2.0-0 libatk-bridge2.0-0 libcups2 libxcomposite-dev libxdamage1 libxrandr2 libgbm-dev libxkbcommon-x11-0 libpangocairo-1.0-0 libasound2

|

- nss.

- gtk2.

- atk.

- libnss3.so.

- libatk-1.0.so.0.

- libxkbcommon.

- libdrm.

- at-spi2-atk.

- mesa-libgbm.

- alsa-lib.

- cups-libs.

- libXcomposite.

- libXdamage.

- libXrandr.

Вы можете установить пакеты с помощью команды:

dnf install nss gtk2 atk libnss3.so libatk-1.0.so.0 libxkbcommon libdrm at-spi2-atk mesa-libgbm alsa-lib cups-libs libXcomposite libXdamage libXrandr

|

Уровень прав пользователя, необходимый для установки программы

|

Нет значения.

|

Вам нужно присвоить необходимый уровень прав пользователю, под которым вы собираетесь устанавливать программу, с помощью команды:

sudo pdpl-user -i 63 <имя пользователя, под которым вы собираетесь устанавливать программу>

|

Нет значения.

|

Нет значения.

|

[Topic 231034]

Обновление с операционной системы Oracle Linux 8.x до Oracle Linux 9.x

Чтобы выполнить обновление с Oracle Linux 8.x до Oracle Linux 9.x:

- Отключите сервисы KUMA на хостах, где сервисы установлены, с помощью следующих команд:

sudo systemctl disable kuma-collector-<идентификатор сервиса>.servicesudo systemctl disable kuma-correlator-<идентификатор сервиса>.servicesudo systemctl disable kuma-storage-<идентификатор сервиса>.servicesudo systemctl disable kuma-grafana.servicesudo systemctl disable kuma-mongodb.servicesudo systemctl disable kuma-victoria-metrics.servicesudo systemctl disable kuma-vmalert.servicesudo systemctl disable kuma-core.service

- Выполните обновление ОС на каждом хосте.

- После обновления установите пакет compat-openssl11 на хосте, где будет разворачиваться Ядро KUMA вне кластера, с помощью следующей команды:

yum install compat-openssl11

- Включите сервисы на хостах, где сервисы установлены, с помощью следующих команд:

sudo systemctl enable kuma-core.servicesudo systemctl enable kuma-storage-<идентификатор сервиса>.servicesudo systemctl enable kuma-collector-<идентификатор сервиса>.servicesudo systemctl enable kuma-correlator-<идентификатор сервиса>.servicesudo systemctl enable kuma-grafana.servicesudo systemctl enable kuma-mongodb.servicesudo systemctl enable kuma-victoria-metrics.servicesudo systemctl enable kuma-vmalert.service

- Перезагрузите хосты.

В результате обновление выполнено.

В начало

[Topic 267523]

Порты, используемые KUMA при установке

Для правильной работы программы нужно убедиться, что компоненты KUMA могут взаимодействовать с другими компонентами и программами по сети через протоколы и порты, указанные во время установки компонентов KUMA.

Перед установкой Ядра на устройстве убедитесь, что следующие порты свободны:

- 9090: используется Victoria Metrics.

- 8880: используется VMalert.

- 27017: используется MongoDB.

В таблице ниже показаны значения сетевых портов по умолчанию. Порты открываются установщиком автоматически при установке KUMA

Сетевые порты, используемые для взаимодействия компонентов KUMA

Протокол

|

Порт

|

Направление

|

Назначение подключения

|

HTTPS

|

7222

|

От клиента KUMA к серверу с компонентом Ядро KUMA.

|

Реверс-прокси к системе CyberTrace.

|

HTTPS

|

8123

|

Локальные обращения от сервиса хранилища к локальному узлу кластера клика.

|

Запись и получение нормализованных событий в кластере ClickHouse.

|

HTTPS

|

8429

|

От агента KUMA к серверу с компонентом Ядро KUMA.

|

Запись метрик работы агента KUMA.

|

HTTPS

|

9009

|

Между репликами кластера ClickHouse.

|

Внутренняя коммуникация между репликами кластера ClickHouse для передачи данных кластера.

|

TCP

|

2181

|

От узлов кластера ClickHouse к сервису координации репликации ClickHouse keeper.

|

Получение и запись репликами серверов ClickHouse метаинформации о реплицировании.

|

TCP

|

2182

|

От сервисов координации репликации ClickHouse keeper друг к другу.

|

Внутренняя коммуникация между сервисами координации репликации, используемая для достижения кворума.

|

TCP

|

7210

|

От всех компонентов KUMA на сервер Ядра KUMA.

|

Получение конфигурации KUMA от сервера Ядра KUMA.

|

TCP

|

7220

|

- От клиента KUMA к серверу с компонентом Ядро KUMA.

- От хостов хранилищ к серверу с компонентом Ядро KUMA во время установки или обновления.

|

- Доступ пользователей к веб-интерфейсу KUMA.

- Взаимодействие хостов хранилищ с Ядром KUMA при установке или обновлении. После установки или обновления порт можно закрыть.

|

TCP

|

7221 и другие порты, используемые для установки сервисов в качестве значения параметра --api.port <порт>

|

От Ядра KUMA к сервисам KUMA.

|

Администрирование сервисов из веб-интерфейса KUMA.

|

TCP

|

7223

|

К серверу Ядра KUMA.

|

Порт, используемый по умолчанию для API-запросов.

|

TCP

|

8001

|

От Victoria Metrics к серверу ClickHouse.

|

Получение метрик работы сервера ClickHouse.

|

TCP

|

9000

|

- Исходящие и входящие соединения между серверами кластера ClickHouse.

- От локального клиента client.sh к локальному узлу кластера.

|

Порт собственного протокола ClickHouse (также называется протокол ClickHouse TCP).

Используется приложениями и процессами ClickHouse, такими как clickhouse-server, clickhouse-client, а также собственными инструментами ClickHouse. Используется для распределенных запросов при взаимодействии между серверами. Также используется для записи и получения данных в кластере ClickHouse.

|

Порты, используемые предустановленными ресурсами из состава OOTB

Порты открываются установщиком автоматически при установке KUMA.

Порты, используемые предустановленными ресурсами из состава OOTB:

- 7230/tcp

- 7231/tcp

- 7232/tcp

- 7233/tcp

- 7234/tcp

- 7235/tcp

- 5140/tcp

- 5140/udp

- 5141/tcp

- 5144/udp

Трафик Ядра KUMA в отказоустойчивой конфигурации

В таблице "Трафик Ядра KUMA в отказоустойчивой конфигурации" указаны инициатор соединения (источник) и назначение. Номер порта на инициаторе может быть динамическим. Обратный трафик в рамках установленного соединения не должен блокироваться.

Трафик Ядра KUMA в отказоустойчивой конфигурации

Источник

|

Назначение

|

Порт назначения

|

Тип

|

Внешние сервисы KUMA

|

Балансировщик нагрузки

|

7209

|

TCP

|

Внешние сервисы KUMA

|

Балансировщик нагрузки

|

7210

|

TCP

|

Внешние сервисы KUMA

|

Балансировщик нагрузки

|

7220

|

TCP

|

Внешние сервисы KUMA

|

Балансировщик нагрузки

|

7222

|

TCP

|

Внешние сервисы KUMA

|

Балансировщик нагрузки

|

7223

|

TCP

|

Агенты KUMA

|

Балансировщик нагрузки

|

8429

|

TCP

|

Рабочий узел

|

Балансировщик нагрузки

|

6443

|

TCP

|

Рабочий узел

|

Балансировщик нагрузки

|

8132

|

TCP

|

Управляющий узел

|

Балансировщик нагрузки

|

6443

|

TCP

|

Управляющий узел

|

Балансировщик нагрузки

|

8132

|

TCP

|

Управляющий узел

|

Балансировщик нагрузки

|

9443

|

TCP

|

Рабочий узел

|

Внешние сервисы KUMA

|

В зависимости от настроек при создании сервиса.

|

TCP

|

Балансировщик нагрузки

|

Рабочий узел

|

7209

|

TCP

|

Балансировщик нагрузки

|

Рабочий узел

|

7210

|

TCP

|

Балансировщик нагрузки

|

Рабочий узел

|

7220

|

TCP

|

Балансировщик нагрузки

|

Рабочий узел

|

7222

|

TCP

|

Балансировщик нагрузки

|

Рабочий узел

|

7223

|

TCP

|

Балансировщик нагрузки

|

Рабочий узел

|

8429

|

TCP

|

Внешние сервисы KUMA

|

Рабочий узел

|

7209

|

TCP

|

Внешние сервисы KUMA

|

Рабочий узел

|

7210

|

TCP

|

Внешние сервисы KUMA

|

Рабочий узел

|

7220

|

TCP

|

Внешние сервисы KUMA

|

Рабочий узел

|

7222

|

TCP

|

Внешние сервисы KUMA

|

Рабочий узел

|

7223

|

TCP

|

Агенты KUMA

|

Рабочий узел

|

8429

|

TCP

|

Рабочий узел

|

Рабочий узел

|

179

|

TCP

|

Рабочий узел

|

Рабочий узел

|

9500

|

TCP

|

Рабочий узел

|

Рабочий узел

|

10250

|

TCP

|

Рабочий узел

|

Рабочий узел

|

51820

|

UDP

|

Рабочий узел

|

Рабочий узел

|

51821

|

UDP

|

Управляющий узел

|

Рабочий узел

|

10250

|

TCP

|

Балансировщик нагрузки

|

Управляющий узел

|

6443

|

TCP

|

Балансировщик нагрузки

|

Управляющий узел

|

8132

|

TCP

|

Балансировщик нагрузки

|

Управляющий узел

|

9443

|

TCP

|

Рабочий узел

|

Управляющий узел

|

6443

|

TCP

|

Рабочий узел

|

Управляющий узел

|

8132

|

TCP

|

Рабочий узел

|

Управляющий узел

|

10250

|

TCP

|

Управляющий узел

|

Управляющий узел

|

2380

|

TCP

|

Управляющий узел

|

Управляющий узел

|

6443

|

TCP

|

Управляющий узел

|

Управляющий узел

|

9443

|

TCP

|

Управляющий узел

|

Управляющий узел

|

10250

|

TCP

|

Консоль управления кластером (CLI)

|

Балансировщик нагрузки

|

6443

|

TCP

|

Консоль управления кластером (CLI)

|

Управляющий узел

|

6443

|

TCP

|

[Topic 217770]

Перевыпуск внутренних CA-сертификатов

Изменено место хранения самоподписанного CA-сертификата и механизм перевыпуска сертификата.

Сертификат хранится в СУБД. Недопустимо применять прежний метод перевыпуска внутренних сертификатов через удаление сертификатов из файловой системы Ядра и перезапуск Ядра. Такой способ приведет к невозможности запустить Ядро. До завершения процесса перевыпуска сертификатов не следует подключать к Ядру новые сервисы.

После того как вы перевыпустите внутренние CA-сертификаты в разделе веб-интерфейса KUMA Параметры → Общие → Перевыпустить внутренние CA-сертификаты, необходимо остановить сервисы, удалить прежние сертификаты из директорий сервисов и вручную перезапустить все сервисы. Перевыпускать внутренние CA-сертификаты могут только пользователи с ролью Главный администратор.

Опция Перевыпустить внутренние CA-сертификаты доступна только пользователю с ролью Главный администратор.

Перевыпуск сертификатов для отдельного сервиса остается прежним: в веб-интерфейсе KUMA в разделе Ресурсы → Активные сервисы необходимо выбрать сервис, выбрать в контекстном меню Сбросить сертификат и удалить прежний сертификат в директории установки сервиса. KUMA автоматически сгенерирует новый сертификат. Для работающих сервисов перезапуск не требуется, новый сертификат будет применен автоматически. Если сервис был остановлен, необходимо перезапустить сервис, чтобы применить новый сертификат.

Чтобы перевыпустить внутренние CA-сертификаты:

- В веб-интерфейсе KUMA перейдите в раздел Параметры → Общие, нажмите кнопку Перевыпустить внутренние CA-сертификаты и ознакомьтесь с отобразившимся предупреждением. Если вы принимаете решение продолжить перевыпуск сертификатов, нажмите Да.

В результате будут перевыпущены CA-сертификаты для сервисов KUMA и CA-сертификат для ClickHouse. Далее вам нужно будет остановить сервисы, удалить прежние сертификаты из директорий установки сервисов, перезапустить Ядро и перезапустить остановленные сервисы, чтобы применить перевыпущенные сертификаты.

- Подключитесь к хостам, где развернуты сервисы коллектора, коррелятора и маршрутизатора событий.

- Остановите все сервисы с помощью следующей команды:

sudo systemctl stop kuma-<collector/correlator/eventRouter>-<ID сервиса>.service

- Удалите файлы сертификатов internal.cert и internal.key из директорий /opt/kaspersky/kuma/<

тип сервиса>/<ID сервиса>/certificates с помощью следующей команды:sudo rm -f /opt/kaspersky/kuma/<тип сервиса>/<ID сервиса>/certificates/internal.cert

sudo rm -f /opt/kaspersky/kuma/<тип сервиса>/<ID сервиса>/certificates/internal.key

- Подключитесь к хостам, где развернуты сервисы хранилища.

- Остановите все сервисы хранилища.

sudo systemctl stop kuma-<storage>-<ID сервиса>.service

- Удалите файлы сертификатов internal.cert и internal.key из директорий /opt/kaspersky/kuma/storage/<

ID сервиса>/certificates. sudo rm -f /opt/kaspersky/kuma/storage/<ID сервиса>/certificates/internal.cert

sudo rm -f /opt/kaspersky/kuma/storage/<ID сервиса>/certificates/internal.key

- Удалите все сертификаты ClickHouse из директории /opt/kaspersky/kuma/clickhouse/certificates.

sudo rm -f /opt/kaspersky/kuma/clickhouse/certificates/internal.cert

sudo rm -f /opt/kaspersky/kuma/clickhouse/certificates/internal.key

- Подключитесь к хостам, где развернуты сервисы агентов.

- Остановите сервисы агентов Windows и агентов Linux.

- Удалите файлы сертификатов internal.cert и internal.key из рабочих директорий агентов.

- Запустите Ядро, чтобы применить новые CA-сертификаты.

- Для установки "all-in-one" и распределенной установки KUMA выполните команду:

sudo systemctl restart kuma-core-00000000-0000-0000-0000-000000000000.service

- Для KUMA в отказоустойчивой конфигурации, чтобы перезапустить Ядро, на основном контоллере выполните следующую команду:

sudo k0s kubectl rollout restart deployment/core-deployment -n kuma

Перезапуск victoria-metrics при этом не потребуется.

Следует выполнять перезапуск Ядра с использованием команды, поскольку перезапуск Ядра через интерфейс KUMA влияет на перезапуск только контейнера Ядра, а не весь под целиком.

- Перезапустите все сервисы, остановленные в ходе выполнения инструкции.

sudo systemctl start kuma-<collector/correlator/eventRouter/storage>-<ID сервиса>.service

- Перезапустите victoria-metrics.

sudo systemctl start kuma-victoria-metrics.service

Внутренние CA-сертификаты перевыпущены и применены.

В начало

[Topic 275543]

Изменение самоподписанного сертификата веб-консоли

Вы можете использовать сертификат и ключ своей компании вместо самоподписанного сертификата веб-консоли. Например, если вы хотите заменить сертификат веб-консоли с самоподписанного CA Core на сертификат, выпущенный корпоративным CA, необходимо предоставить external.cert и незашифрованный external.key в формате PEM.

В следующем примере показано, как заменить самоподписанный CA Core с помощью корпоративного сертификата в формате PFX. Вы можете использовать инструкцию в качестве примера и адаптировать шаги в соответствии со своими потребностями.

Чтобы заменить сертификат веб-консоли KUMA на сертификат external:

- Если вы используете сертификат и ключ в PFX контейнере, в OpenSSL конвертируйте файл PFX в сертификат и зашифрованный ключ в формате PEM:

openssl pkcs12 -in kumaWebIssuedByCorporateCA.pfx -nokeys -out external.cert

openssl pkcs12 -in kumaWebIssuedByCorporateCA.pfx -nocerts -nodes -out external.key

При выполнении команды потребуется указать пароль от ключа PFX (Enter Import Password).

В результате получен сертификат external.cert и ключ external.key в формате PEM.

- В веб-интерфейсе KUMA перейдите в раздел Параметры → Общие → Параметры Ядра. В блоке параметров Внешняя TLS-пара нажмите Загрузить сертификат и Загрузить ключ и загрузите external.cert и незашифрованный external.key в формате PEM.

- Перезапустите KUMA:

systemctl restart kuma-core

- Обновите страницу или перезапустите браузер, с помощью которого вы работаете в веб-интерфейсе KUMA.

Сертификат и ключ вашей компании заменены.

В начало

[Topic 217747]

Синхронизация времени на серверах

Чтобы настроить синхронизацию времени на серверах:

- Установите chrony с помощью следующей команды:

sudo apt install chrony

- Настройте синхронизацию системного времени с NTP-сервером:

- Убедитесь, что виртуальная машина имеет доступ в интернет.

Если доступ есть, вы можете перейти к шагу b.

Если доступ отсутствует, отредактируйте файл /etc/chrony.conf, заменив значение 2.pool.ntp.org на имя или IP-адрес внутреннего NTP-сервера вашей организации.

- Запустите сервис синхронизации системного времени, выполнив следующую команду:

sudo systemctl enable --now chronyd

- Через несколько секунд выполните следующую команду:

sudo timedatectl | grep 'System clock synchronized'

Если системное время синхронизировано верно, вывод будет содержать строку System clock synchronized: yes.

Синхронизация настроена.

В начало

[Topic 255123]

О файле инвентаря

Установка, обновление и удаление компонентов KUMA производится из папки с распакованным установщиком kuma-ansible-installer с помощью инструмента Ansible и созданного вами файла инвентаря. Вы можете указать значения параметров конфигурации KUMA в файле инвентаря, а установщик использует эти значения при развертывании, обновлении и удалении программы. Файл инвентаря имеет формат YAML.

Вы можете создать файл инвентаря на основе шаблонов, включенных в поставку. Доступны следующие шаблоны:

- single.inventory.yml.template – используется для установки KUMA на одном сервере. Содержит минимальный набор параметров, оптимизированный для установки на одном устройстве, без использования кластера Kubernetes.

- distributed.inventory.yml.template – используется для первоначальной распределенной установки KUMA без использования кластера Kubernetes, расширения установки "все в одном" до распределенной и для обновления KUMA.

- expand.inventory.yml.template – используется в ряде сценариев изменения конфигурации: для добавления серверов коллекторов и серверов корреляторов, для расширения существующего кластера хранения и добавления нового кластера хранения. Если вы используете этот файл инвентаря для изменения конфигурации, установщик не останавливает сервисы во всей инфраструктуре. Установщик может останавливать только те сервисы, которые размещены на хостах, перечисленных в файле инвентаря expand.inventory.yml, если вы повторно используете файл инвентаря.

- k0s.inventory.yml.template – используется для установки или переноса KUMA в кластер Kubernetes.

Мы рекомендуем сохранить файл инвентаря, который вы использовали для установки программы. С его помощью вы можете дополнить систему компонентами или удалить KUMA.

В начало

[Topic 255188]

Параметры конфигурации KUMA в файле инвентаря

Файл инвентаря может содержать следующие блоки:

Для каждого хоста вам нужно указать FQDN в формате <имя хоста>.<домен> и при необходимости IPv4-адрес или IPv6-адрес. Имя домена Ядра KUMA и его поддомены не должны начинаться с цифры.

Пример:

hosts:

hostname.example.com:

ip: 0.0.0.0

|

Блок all

В этом блоке вы можете указать переменные, которые распространяются на все хосты, указанные в файле инвентаря, включая неявно заданный localhost, на котором запущена установка. Переменные можно переопределять на уровне групп хостов или отдельных хостов.

Пример переопределения переменных в файле инвентаря

all:

vars:

ansible_connection: ssh

deploy_to_k8s: False

need_transfer: False

airgap: True

deploy_example_services: True

kuma:

vars:

ansible_become: true

ansible_user: i.ivanov

ansible_become_method: su

ansible_ssh_private_key_file: ~/.ssh/id_rsa

children:

kuma_core:

vars:

ansible_user: p.petrov

ansible_become_method: sudo

В таблице ниже приведен список возможных переменных в разделе vars и их описание.

Список возможных переменных в разделе vars

Переменная

|

Описание

|

ansible_connection

|

Способ подключения к целевым машинам.

Возможные значения:

ssh – подключение к удаленным хостам по SSH.local – подключение к удаленным хостам не производится.

|

ansible_user

|

Имя пользователя, от которого производится подключение к целевым машинам и установка компонентов.

Если пользователь root на целевых машинах заблокирован, вам нужно использовать имя пользователя, имеющего право на подключение по SSH и повышение привилегий через su или sudo.

|

ansible_become

|

Переменная, определяющая, требуется ли повышать привилегии пользователя, от имени которого осуществляется установка компонентов KUMA.

Возможные значения:

true – вам нужно указать это значение, если для переменной ansible_user вы не указали значение root.false.

|

ansible_become_method

|

Способ повышения привилегий пользователя, от имени которого осуществляется установка компонентов KUMA.

Вам нужно указать значение su или sudo, если для переменной ansible_user вы не указали значение root.

|

ansible_ssh_private_key_file

|

Путь к закрытому ключу в формате /<путь>/.ssh/id_rsa. Вам нужно указать эту переменную, если вы хотите указать файл ключа, отличный от файла ключа по умолчанию ~/.ssh/id_rsa.

|

deploy_to_k8s

|

Переменная, определяющая, требуется ли разворачивать компоненты KUMA в кластере Kubernetes.

Возможные значения:

false – это значение указано в шаблонах файла инвентаря single.inventory.yml и distributed.inventory.yml.true – это значение указано в шаблоне файла инвентаря k0s.inventory.yml.

Если вы не укажете эту переменную, по умолчанию будет использовано значение false.

|

need_transfer

|

Переменная, определяющая, требуется ли переносить Ядро KUMA в новый кластер Kubernetes.

Вам нужно указать эту переменную, только если для переменной deploy_to_k8s вы указали значение true.

Возможные значения:

Если вы не укажете эту переменную, по умолчанию будет использовано значение false.

|

no_firewall_actions

|

Переменная, определяющая, выполняет ли установщик шаги по настройке межсетевого экрана на хостах.

Возможные значения:

true – при запуске установщик не выполняет шаги по настройке межсетевого экрана на хостах.false – при запуске установщик выполняет шаги по настройке межсетевого экрана на хостах. Это значение указано во всех шаблонах файла инвентаря.

Если вы не укажете эту переменную, по умолчанию будет использовано значение false.

|

generate_etc_hosts

|

Переменная, определяющая, регистрируются ли машины в DNS-зоне вашей организации.

Установщик автоматически дополнит файлы /etc/hosts на машинах, на которые устанавливаются компоненты KUMA, IP-адресами машин из файла инвентаря. Указанные IP-адреса должны быть уникальными.

Возможные значения:

Если вы не укажете эту переменную, по умолчанию будет использовано значение false.

|

deploy_example_services

|

Переменная, определяющая, создаются ли предустановленные сервисы при установке KUMA.

Вам нужно указать эту переменную, если вы хотите создать демо-сервисы независимо от файла инвентаря single/distributed/k0s.

Возможные значения:

false – предустановленные сервисы не создаются при установке KUMA. Это значение указано во всех шаблонах файла инвентаря.true – предустановленные сервисы создаются при установке KUMA.

Если вы не укажете эту переменную, по умолчанию будет использовано значение false.

|

low_resources

|

Переменная, определяющая, устанавливается ли KUMA в окружениях с ограниченными вычислительными ресурсами.

Эта переменная отсутствует во всех шаблонах файла инвентаря.

Возможные значения:

false – KUMA устанавливается для промышленной эксплуатации. В этом случае установщик проверяет требования рабочих узлов (процессор, ОЗУ и свободное дисковое пространство) в соответствии с аппаратными и программными требованиями. Если требования не выполняются, установка прерывается с сообщением об ошибке.true – KUMA устанавливается в окружениях с ограниченными вычислительными ресурсами. В этом случае минимальный объем директории для установки Ядра KUMA на хосте составляет 4 ГБ. Ограничения для других вычислительных ресурсов отсутствуют.

Если вы не укажете эту переменную, по умолчанию будет использовано значение false.

|

Блок kuma

В этом блоке вы можете указать параметры компонентов KUMA, развернутых вне кластера Kubernetes. Блок kuma может содержать следующие разделы:

vars – переменные, которые распространяются на все хосты, указанные в блоке kuma. children – группы параметров компонентов:kuma_core – параметры Ядра KUMA. Вы можете указать только один хост и следующие параметры ротации журнала базы данных MongoDB для хоста:mongo_log_archives_number – количество предыдущих журналов, которые сохраняются при ротации журнала базы данных MongoDB.mongo_log_file_size – размер журнала базы данных MongoDB в гигабайтах, при котором начинается ротация. Если журнал базы данных MongoDB не превышает указанный размер, ротации не происходит.mongo_log_frequency_rotation – интервал проверки размера журнала базы данных MongoDB для ротации. Возможные значения:hourly – размер журнала базы данных MongoDB проверяется каждый час.daily – размер журнала базы данных MongoDB проверяется каждый день.weekly – размер журнала базы данных MongoDB проверяется каждую неделю.

Журнал базы данных MongoDB содержится в директории /opt/kaspersky/kuma/mongodb/log.

raft_node_addr – FQDN, на котором raft будет слушать сигналы от других узлов. Значение параметра следует указывать в следующем формате: <FQDN хоста>:<порт>. Если значение параметра не указано явно, то в качестве <FQDN хоста> по умолчанию принимается FQDN, где разворачивается Ядро KUMA, а <порт> - 7209. Вы можете указать произвольный адрес, чтобы адаптировать Ядро KUMA под специфику своей инфраструктуры.

kuma_collector – параметры коллекторов KUMA. Вы можете указать несколько хостов.kuma_correlator – параметры корреляторов KUMA. Вы можете указать несколько хостов.kuma_storage – параметры узлов хранилища KUMA. Вы можете указать несколько хостов, а также идентификаторы шарда, реплики и кипера для хостов с помощью следующих параметров:shard – идентификатор шарда.replica – идентификатор реплики.keeper – идентификатор кипера.

Указанные идентификаторы шарда, реплики и кипера используются, только если вы разворачиваете демо-сервисы при новой установке KUMA. В остальных случаях используются идентификаторы шарда, реплики и кипера, которые вы указали в веб-интерфейсе KUMA при создании набора ресурсов для хранилища.

Блок kuma_k0s

В этом блоке вы можете указать параметры кластера Kubernetes, использование которого обеспечивает отказоустойчивость KUMA. Этот блок указан только в файле инвентаря, основанном на шаблоне файла инвентаря k0s.inventory.yml.template.

Для тестовой и демонстрационной установки в окружениях с ограниченными вычислительными ресурсами вам нужно указать переменную low_resources: true в блоке all. В этом случае минимальный объем директории для установки ядра KUMA будет снижен до 4 ГБ и ограничения для других вычислительных ресурсов не будут указаны.

Для каждого хоста в блоке kuma_k0s должен быть указан уникальный FQDN и IP-адрес с помощью переменной ansible_host, кроме хоста в разделе kuma_lb. Для хоста в разделе kuma_lb должен быть указан только FQDN. Хосты в группах не должны повторяться.

Для демонстрационной установки допустимо совместить контроллер с рабочим узлом. Такая конфигурация не обеспечивает отказоустойчивости Ядра KUMA и служит для демонстрации возможностей или проверки программной среды.

Минимальная конфигурация для обеспечения отказоустойчивости составляет 3 контроллера, 2 рабочих узла и 1 балансировщик нагрузки nginx. Для промышленной эксплуатации рекомендуется использовать отдельные рабочие узлы и контроллеры. Если контроллер кластера находится под рабочей нагрузкой и под (англ. pod) с Ядром KUMA размещается на контроллере, выключение контроллера приведет к полной потере доступа к Ядру KUMA.

Блок kuma_k0s может содержать следующие разделы:

vars – переменные, которые распространяются на все хосты, указанные в блоке kuma.сhildren – параметры кластера Kubernetes, использование которого обеспечивает отказоустойчивость KUMA.

В таблице ниже приведен список возможных переменных в разделе vars и их описание.

Список возможных переменных в разделе vars

|

|

|

Группа переменных

|

Описание

|

kuma_lb

|

FQDN балансировщика нагрузки. Вы можете установить балансировщик нагрузки nginx или сторонний TCP-балансировщик нагрузки.

Если вы устанавливаете балансировщик нагрузки nginx, вы можете указать параметр kuma_managed_lb = true, чтобы автоматически настроить балансировщик нагрузки nginx при установке KUMA, открыть на хосте балансировщика нагрузки nginx необходимые сетевые порты (6443, 8132, 9443, 7209, 7210, 7220, 7222, 7223, 7226, 8429), а также выполнить перезагрузку для применения изменений.

Если вы устанавливаете сторонний TCP-балансировщик нагрузки, вам нужно вручную настроить его до установки KUMA.

|

kuma_control_plane_master

|

Хост, выполняющий роль главного контроллера в кластере.

|

Группы для указания главного контроллера. Вам нужно указать хост только для одной группы.

|

kuma_control_plane_master_worker

|

Хост, совмещающий роль главного контроллера и рабочего узла в кластере.Для каждого контроллера кластера, совмещенного с рабочим узлом, в файле инвентаря должен быть указан параметр extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true".

|

kuma_control_plane

|

Хосты, выполняющие роль контроллера в кластере.

|

Группы для указания второстепенных контроллеров.

|

kuma_control_plane_worker

|

Хосты, совмещающие роль контроллера и рабочего узла в кластере. Для каждого контроллера кластера, совмещенного с рабочим узлом, в файле инвентаря должен быть указан параметр extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true".

|

kuma_worker

|

Рабочие узлы кластера. Для каждого рабочего узла в файле инвентаря должен быть указан параметр extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true".

|

[Topic 244406][Topic 217908]

Подготовка файла инвентаря single.inventory.yml

Установка, обновление и удаление компонентов KUMA производится из папки с распакованным установщиком с помощью инструмента Ansible и созданного пользователем файла инвентаря в формате YML с перечнем хостов компонентов KUMA и других параметров. Если вы хотите установить все компоненты KUMA на одном сервере, следует указать в файле инвентаря один и тот же хост для всех компонентов.

Чтобы создать файл инвентаря для установки на одном сервере:

- Скопируйте архив с установщиком

kuma-ansible-installer-<номер версии>.tar.gz на сервер и распакуйте его с помощью следующей команды (потребуется около 2 ГБ дискового пространства):sudo tar -xpf kuma-ansible-installer-<номер версии>.tar.gz

- Перейдите в директорию установщика KUMA, выполнив следующую команду:

cd kuma-ansible-installer

- Скопируйте шаблон single.inventory.yml.template и создайте файл инвентаря с именем single.inventory.yml:

cp single.inventory.yml.template single.inventory.yml

- Отредактируйте параметры файла инвентаря single.inventory.yml.

Если вы хотите, чтобы при установке были созданы предустановленные сервисы, присвойте параметру deploy_example_services значение true.

deploy_example_services: true

Предустановленные сервисы появятся только при первичной установке KUMA. При обновлении системы с помощью того же файла инвентаря предустановленные сервисы повторно созданы не будут.

- Замените в файле инвентаря все строки

kuma.example.com на имя хоста, на который следует установить компоненты KUMA.

Файл инвентаря создан. С его помощью можно установить KUMA на одном сервере.

Мы рекомендуем сохранить файл инвентаря, который вы использовали для установки программы. С его помощью вы можете дополнить систему компонентами или удалить KUMA.

Пример файла инвентаря для установки на одном сервере

all:

vars:

deploy_to_k8s: false

need_transfer: false

generate_etc_hosts: false

deploy_example_services: true

no_firewall_actions: false

kuma:

vars:

ansible_connection: ssh

ansible_user: root

children:

kuma_core:

hosts:

kuma1.example.com:

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma1.example.com

kuma_correlator:

hosts:

kuma1.example.com

kuma_storage:

hosts:

kuma1.example.com:

shard: 1

replica: 1

keeper: 1

[Topic 222158]

Установка программы на одном сервере

Вы можете установить все компоненты KUMA на одном сервере с помощью инструмента Ansible и файла инвентаря single.inventory.yml.

Чтобы установить KUMA на одном сервере:

- Скачайте на сервер дистрибутив KUMA kuma-ansible-installer-<

номер сборки>.tar.gz и распакуйте его. Архив распаковывается в папку kuma-ansibleinstaller. - Войдите в папку с распакованным установщиком.

- В зависимости от типа активации лицензии, который вы планируете использовать, выберите один из вариантов:

- Если вы планируете использовать активацию лицензии файлом, поместите в папку <папка установщика>/roles/kuma/files/ файл с лицензионным ключом.

Файл ключа должен иметь название license.key.

sudo cp <файл ключа>.key <папка установщика>/roles/kuma/files/license.key

- Если вы планируете использовать активацию с помощью лицензионного кода, переходите к следующему пункту инструкции.

Активация с помощью лицензионного кода доступна только для KUMA версии 3.4. Для более ранних версий KUMA используется активация лицензии файлом.

- Запустите установку компонентов с использованием подготовленного файла инвентаря single.inventory.yml с помощью следующей команды:

sudo ./install.sh single.inventory.yml

- Примите условия Лицензионного соглашения.

Если вы не примете условия Лицензионного соглашения, программа не будет установлена.

В зависимости от типа активации лицензии результатом запуска установщика будет один из следующих вариантов:

- Если вы планируете использовать активацию лицензии файлом и поместили файл с лицензионным ключом в папку <папка установщика>/roles/kuma/files/, в результате запуска установщика с инвентарем single.inventory.yml будет установлено Ядро KUMA, все заданные в файле инвентаря сервисы и OOTB-ресурсы. Если в инвентаре был задан параметр example_services=true, демонстрационные сервисы будут установлены.

- Если вы планируете использовать активацию с помощью лицензионного кода, или планируете предоставить лицензионный файл позднее, в результате запуска установщика с инвентарем single.inventory.yml будет установлено только Ядро KUMA.

Чтобы установить сервисы, в консоли командной строки укажите лицензионный код. Затем запустите установщик postinstall.sh с файлом инвентаря single.inventory.yml.

sudo ./postinstall.sh single.inventory.yml

В результате будут созданы заданные сервисы. Вы можете выбрать, какие ресурсы вы хотите импортировать из репозитория.

- По окончании установки войдите в веб-интерфейс KUMA и в строке браузера введите адрес веб-интерфейса KUMA, а затем на странице входа введите учетные данные.

Адрес веб-интерфейса KUMA – https://<FQDN хоста, на котором установлена KUMA>:7220.

Учетные данные для входа по умолчанию:

- логин – admin

- пароль – mustB3Ch@ng3d!

После первого входа измените пароль учетной записи admin

Все компоненты KUMA установлены и выполнен вход в веб-интерфейс.

Мы рекомендуем сохранить файл инвентаря, который вы используете для установки программы. С помощью этого файла инвентаря можно будет дополнить систему компонентами или удалить KUMA.

Установку можно расширить до распределенной.

В начало

[Topic 222159][Topic 217917]

Подготовка контрольной машины

Чтобы подготовить контрольную машину для установки KUMA:

- Убедитесь, что соблюдены аппаратные и программные требования, а также требования к установке программы.

- Сгенерируйте SSH-ключ для аутентификации на SSH-серверах целевых машин, выполнив следующую команду:

sudo ssh-keygen -f /root/.ssh/id_rsa -N "" -C kuma-ansible-installer

Если на контрольной машине заблокирован доступ root по SSH, сгенерируйте SSH-ключ для аутентификации на SSH-серверах целевых машин с помощью пользователя из группы sudo:

Если у пользователя нет прав sudo, добавьте пользователя в группу sudo:

usermod -aG sudo user

ssh-keygen -f /home/<имя пользователя из группы sudo>/.ssh/id_rsa -N "" -C kuma-ansible-installer

В результате ключ будет сгенерирован и сохранен в домашней директории пользователя. Вам следует указать полный путь к ключу в файле инвентаря в значении параметра ansible_ssh_private_key_file, чтобы ключ был доступен при установке.

- Убедитесь, что контрольная машина имеет сетевой доступ ко всем целевым машинам по имени хоста и скопируйте SSH-ключ на каждую целевую машину, выполнив следующую команду:

sudo ssh-copy-id -i /root/.ssh/id_rsa root@<имя хоста контрольной машины>

Если на контрольной машине заблокирован доступ root по SSH и вы хотите использовать ключ SSH из домашней директории пользователя из группы sudo, убедитесь, что контрольная машина имеет сетевой доступ ко всем целевым машинам по имени хоста и скопируйте SSH-ключ на каждую целевую машину, выполнив следующую команду:

ssh-copy-id -i /home/<имя пользователя из группы sudo>/.ssh/id_rsa <имя пользователя из группы sudo>@<имя хоста контрольной машины>

- Скопируйте архив с установщиком

kuma-ansible-installer-<version>.tar.gz на контрольную машину и распакуйте его с помощью следующей команды (потребуется около 2 ГБ дискового пространства):sudo tar -xpf kuma-ansible-installer-<номер версии>.tar.gz

Контрольная машина готова для установки KUMA.

В начало

[Topic 222083]

Подготовка целевой машины

Чтобы подготовить целевую машину для установки компонентов KUMA:

- Убедитесь, что соблюдены аппаратные и программные требования, а также требования к установке.

- Установите имя хоста. Мы рекомендуем указывать FQDN. Например: kuma1.example.com.

Не следует изменять имя хоста KUMA после установки: это приведет к невозможности проверки подлинности сертификатов и нарушит сетевое взаимодействие между компонентами программы.

- Зарегистрируйте целевую машину в DNS-зоне вашей организации для преобразования имен хостов в IP-адреса.

Если в вашей организации не используется DNS-сервер, вы можете использовать для преобразования имен файл /etc/hosts. Содержимое файлов можно автоматически создать для каждой целевой машины при установке KUMA.

- Чтобы получить имя хоста, которое потребуется указать при установке KUMA, выполните следующую команду и запишите результат:

hostname -f

Целевая машина должна быть доступна по этому имени для контрольной машины.

Целевая машина готова для установки компонентов KUMA.

В начало

[Topic 217955]

Подготовка файла инвентаря distributed.inventory.yml

Чтобы создать файл инвентаря distributed.inventory.yml:

- Перейдите в директорию установщика KUMA, выполнив следующую команду:

cd kuma-ansible-installer

- Скопируйте шаблон distributed.inventory.yml.template и создайте файл инвентаря с именем distributed.inventory.yml:

cp distributed.inventory.yml.template distributed.inventory.yml

- Отредактируйте параметры файла инвентаря distributed.inventory.yml.

Мы рекомендуем сохранить файл инвентаря, который вы использовали для установки программы. С его помощью вы можете дополнить систему компонентами или удалить KUMA.

Пример файла инвентаря для Распределенной схемы установки

all:

vars:

deploy_to_k8s: false

need_transfer: false

generate_etc_hosts: false

deploy_example_services: false

no_firewall_actions: false

kuma:

vars:

ansible_connection: ssh

ansible_user: root

children:

kuma_core:

hosts:

kuma-core-1.example.com:

ip: 0.0.0.0

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma-collector-1.example.com:

ip: 0.0.0.0

kuma_correlator:

hosts:

kuma-correlator-1.example.com:

ip: 0.0.0.0

kuma_storage:

hosts:

kuma-storage-cluster1-server1.example.com:

ip: 0.0.0.0

shard: 1

replica: 1

keeper: 0

kuma-storage-cluster1-server2.example.com:

ip: 0.0.0.0

shard: 1

replica: 2

keeper: 0

kuma-storage-cluster1-server3.example.com:

ip: 0.0.0.0

shard: 2

replica: 1

keeper: 0

kuma-storage-cluster1-server4.example.com:

ip: 0.0.0.0

shard: 2

replica: 2

keeper: 0

kuma-storage-cluster1-server5.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 1

kuma-storage-cluster1-server6.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 2

kuma-storage-cluster1-server7.example.com:

ip: 0.0.0.0

shard: 0

replica: 0

keeper: 3

[Topic 222085]

Установка программы в распределенной конфигурации

Установка KUMA производится помощью инструмента Ansible и YML-файла инвентаря. Установка производится с контрольной машины, при этом все компоненты KUMA устанавливаются на целевых машинах.

Чтобы установить KUMA:

- На контрольной машине войдите в папку с распакованным установщиком.

cd kuma-ansible-installer

- В зависимости от типа активации лицензии, который вы планируете использовать, выберите один из вариантов:

- Запустите установку компонентов с использованием подготовленного файла инвентаря distributed.inventory.yml, находясь в папке с распакованным установщиком:

sudo ./install.sh distributed.inventory.yml

- Примите условия Лицензионного соглашения.

Если вы не примете условия Лицензионного соглашения, программа не будет установлена.

В зависимости от типа активации лицензии результатом запуска установщика будет один из следующих вариантов:

- Если вы планируете использовать активацию лицензии файлом и поместили файл с лицензионным ключом в папку <папка установщика>/roles/kuma/files/, в результате запуска установщика с файлом инвентаря distributed.inventory.yml будет установлено Ядро KUMA, все заданные в файле инвентаря сервисы и OOTB-ресурсы.

- Если вы планируете использовать активацию с помощью лицензионного кода, или планируете предоставить лицензионный файл позднее, в результате запуска установщика с файлом инвентаря distributed.inventory.yml будет установлено только Ядро KUMA.

Чтобы установить сервисы, в консоли командной строки укажите лицензионный код. Затем запустите установщик postinstall.sh с файлом инвентаря distributed.inventory.yml.

sudo ./postinstall.sh distributed.inventory.yml

В результате будут созданы заданные сервисы. Вы можете выбрать, какие ресурсы вы хотите импортировать из репозитория.

- По окончании установки войдите в веб-интерфейс KUMA и в строке браузера введите адрес веб-интерфейса KUMA, а затем на странице входа введите учетные данные.

Адрес веб-интерфейса KUMA – https://<FQDN хоста, на котором установлена KUMA>:7220.

Учетные данные для входа по умолчанию:

- логин – admin

- пароль – mustB3Ch@ng3d!

После первого входа измените пароль учетной записи admin

Все компоненты KUMA установлены и выполнен вход в веб-интерфейс.

Мы рекомендуем сохранить файл инвентаря, который вы используете для установки программы. С помощью этого файла инвентаря можно будет дополнить систему компонентами или удалить KUMA.

В начало

[Topic 217914]

Распределенная установка в отказоустойчивой конфигурации

Вы можете обеспечить отказоустойчивость KUMA путем развертывания Ядра KUMA в кластере Kubernetes, а также использования внешнего балансировщика TCP-трафика.

Для установки KUMA в отказоустойчивом исполнении используется установщик kuma-ansible-installer-ha-<номер сборки>.tar.gz и подготовленный вами файл инвентаря k0s.inventory.yml, в котором вы определите конфигурацию кластера. При новой установке в отказоустойчивой конфигурации всегда импортируются ресурсы OOTB. Вы можете выполнить установку с развертыванием демонстрационных сервисов. Для этого нужно в файле инвентаря указать параметр deploy_example_services: true.

Поместить Ядро KUMA в кластер Kubernetes можно следующими способами:

Минимальная конфигурация

В Kubernetes существует 2 роли узлов:

- контроллеры (control-plane) – узлы с этой ролью управляют кластером, хранят метаданные и распределяют рабочую нагрузку.

- рабочие (worker) – узлы с этой ролью несут полезную рабочую нагрузку, то есть размещают процессы KUMA.

Для выполнения установки KUMA в отказоустойчивой конфигурации вам понадобится:

- 3 выделенных контроллера;

- 2 рабочих узла;

- 1 TCP балансировщик.

Не следует использовать балансировщик в качестве контрольной машины для запуска установщика KUMA.

Для эффективной работы Ядра KUMA в Kubernetes необходимо выделить 3 обособленных узла с единственной ролью контроллера. Это позволит обеспечить отказоустойчивость самого кластера Kubernetes и гарантировать, что рабочая нагрузка - процессы KUMA и другие процессы - не повлияет на задачи, связанные с управлением кластером Kubernetes. В случае использования средств виртуализации следует убедиться, что узлы размещены на разных физических серверах и эти физические серверы не выполняют роль рабочих узлов.

В случае демонстрационной установки KUMA допустимо совмещать роли контроллера и рабочего узла. Однако при расширении установки до распределенной необходимо переустановить кластер Kubernetes целиком, выделив 3 отдельных узла с ролью контроллера и как минимум 2 узла с ролью рабочего узла. Обновление KUMA до следующих версий недоступно при наличии узлов, совмещающих роли контроллера и рабочего узла.

В начало

[Topic 244396]

Дополнительные требования при развертывании Ядра в Kubernetes

Если вы планируете защитить сетевую инфраструктуру KUMA с помощью программы Kaspersky Endpoint Security for Linux, вам нужно сначала установить KUMA в кластере Kubernetes и только потом разворачивать Kaspersky Endpoint Security for Linux. При обновлении или удалении KUMA вам нужно предварительно остановить Kaspersky Endpoint Security for Linux с помощью команды:

systemctl stop kesl

При установке KUMA в отказоустойчивом варианте должны выполняться следующие требования:

- Общие требования к установке программы.

- На хостах, которые планируются под узлы кластера Kubernetes, не используются IP-адреса из следующих блоков Kubernetes:

- serviceCIDR: 10.96.0.0/12;

- podCIDR: 10.244.0.0/16.

Для IP-адресов из блоков исключен трафик на прокси-серверы.

- Каждый хост имеет уникальный идентификатор (/etc/machine-id).

- На хостах установлен и включен инструмент для управления межсетевым экраном firewalld или uwf для внесения правил в iptables.

- Установлен и настроен балансировщик нагрузки nginx (дополнительные сведения см. в документации балансировщика нагрузки nginx). Вы можете установить балансировщик нагрузки nginx с помощью одной из следующих команд:

sudo yum install nginx – для операционной системы Oracle Linux.sudo apt install nginx-full – для операционной системы Astra Linux.sudo apt install nginx libnginx-mod-stream – для операционной системы Ubuntu.sudo yum install nginx nginx-all-modules – для операционной системы РЕД ОС.

Если вы хотите, чтобы балансировщик нагрузки nginx был настроен автоматически в процессе установки KUMA, установите балансировщик нагрузки nginx и откройте к нему доступ по SSH так же, как для хостов кластера Kubernetes.

Пример автоматически созданной конфигурации nginx

Установщик создает файл конфигурации /etc/nginx/kuma_nginx_lb.conf, пример содержимого которого приведен ниже. Разделы upstream формируются динамически и содержат IP-адреса контроллеров кластера Kubernetes (в примере – 10.0.0.2-4 в разделах upstream kubeAPI_backend, upstream konnectivity_backend, controllerJoinAPI_backend) и IP-адреса рабочих узлов (в примере 10.0.1.2-3), для которых в файле инвентаря в переменной extra_args содержится значение "kaspersky.com/kuma-ingress=true".

В конец файла /etc/nginx/nginx.conf дописывается строка "include /etc/nginx/kuma_nginx_lb.conf;", позволяющая применить сформированный файл конфигурации. При большом количестве активных сервисов и пользователей может понадобиться увеличить лимит открытых файлов в параметрах nginx.conf.

Пример файла конфигурации:

# Ansible managed

#

# LB KUMA cluster

#

stream {

server {

listen 6443;

proxy_pass kubeAPI_backend;

}

server {

listen 8132;

proxy_pass konnectivity_backend;

}

server {

listen 9443;

proxy_pass controllerJoinAPI_backend;

}

server {

listen 7209;

proxy_pass kuma-core-hierarchy_backend;

proxy_timeout 86400s;

}

server {

listen 7210;

proxy_pass kuma-core-services_backend;

proxy_timeout 86400s;

}

server {

listen 7220;

proxy_pass kuma-core-ui_backend;

proxy_timeout 86400s;

}

server {

listen 7222;

proxy_pass kuma-core-cybertrace_backend;

proxy_timeout 86400s;

}

server {

listen 7223;

proxy_pass kuma-core-rest_backend;

proxy_timeout 86400s;

}

upstream kubeAPI_backend {

server 10.0.0.2:6443;

server 10.0.0.3:6443;

server 10.0.0.4:6443;

}

upstream konnectivity_backend {

server 10.0.0.2:8132;

server 10.0.0.3:8132;

server 10.0.0.4:8132;

}

upstream controllerJoinAPI_backend {

server 10.0.0.2:9443;

server 10.0.0.3:9443;

server 10.0.0.4:9443;

}

upstream kuma-core-hierarchy_backend {

server 10.0.1.2:7209;

server 10.0.1.3:7209;

}

upstream kuma-core-services_backend {

server 10.0.1.2:7210;

server 10.0.1.3:7210;

}

upstream kuma-core-ui_backend {

server 10.0.1.2:7220;

server 10.0.1.3:7220;

}

upstream kuma-core-cybertrace_backend {

server 10.0.1.2:7222;

server 10.0.1.3:7222;

}

upstream kuma-core-rest_backend {

server 10.0.1.2:7223;

server 10.0.1.3:7223;

}

worker_rlimit_nofile 1000000;

events {

worker_connections 20000;

}

# worker_rlimit_nofile – ограничение на максимальное число открытых файлов (RLIMIT_NOFILE) для рабочих процессов. Используется для увеличения ограничения без перезапуска главного процесса.

# worker_connections – максимальное число соединений, которые одновременно может открыть рабочий процесс.

- На сервере балансировщика нагрузки nginx добавлен ключ доступа с устройства, с которого осуществляется установка KUMA.

- На сервере балансировщика нагрузки nginx в операционной системе не включен модуль SELinux.

- На хостах установлены пакеты tar, systemctl.

При установке KUMA автоматически проверяется соответствие хостов следующим аппаратным требованиям:

- Количество ядер CPU (потоков) – 12 или больше.

- ОЗУ – 22528 МБ или больше.

- Объем свободного пространства на диске в разделе /opt/ – 1000 ГБ или больше.

- Если производится первичная установка, в /var/lib/ должно быть не менее 32GB свободного места. Если установка кластера на этот узел ранее уже проводилась, размер требуемого свободного пространства уменьшается на размер директории /var/lib/k0s.

Если условия не выполняются, установка прерывается. Проверку условий при установке для демонстрации можно выключить, указав в файле инвентаря переменную low_resources: true.

Дополнительные требования при установке на операционной системе Astra Linux или Ubuntu

Дополнительные требования при установке на операционной системе Oracle Linux, РЕД ОС и на операционных системах Red Hat Enterprise Linux

На машинах, предназначенных для развертывания кластера Kubernetes, установлены следующие пакеты:

- iscsi-initiator-utils;

- wireguard-tools.

Перед установкой пакетов на операционной системе Oracle Linux вам нужно добавить репозиторий EPEL в качестве источника с помощью одной из следующих команд:

sudo yum install oracle-epel-release-el8 - для операционной системы Oracle Linux 8.sudo yum install oracle-epel-release-el9 - для операционной системы Oracle Linux 9.

Вы можете установить пакеты с помощью команды:

sudo yum install iscsi-initiator-utils wireguard-tools

В начало

[Topic 244399]

Установка KUMA в кластере Kubernetes с нуля

Распределенная установка KUMA происходит в несколько этапов:

- Проверка соблюдения аппаратных и программных требований, а также требований к установке KUMA.

- Подготовка контрольной машины.

Контрольная машина используется в процессе установки программы: на ней распаковывается и запускаются файлы установщика.

- Подготовка целевых машин.

На целевые машины устанавливаются компоненты программы.

- Подготовка файла инвентаря k0s.inventory.yml.

Создайте файл инвентаря с описанием сетевой структуры компонентов программы. С помощью этого файла инвентаря установщик развернет KUMA.

- Установка программы.

Установите программу и войдите в веб-интерфейс.

- Создание сервисов.

Создайте клиентскую часть сервисов в веб-интерфейсе KUMA и установите серверную часть сервисов на целевых машинах.

Сервисы KUMA следует устанавливать только после завершения установки KUMA. Мы рекомендуем устанавливать сервисы в такой последовательности: хранилище, коллекторы, корреляторы и агенты.

При развертывании нескольких сервисов KUMA на одном хосте в процессе установки требуется указать уникальные порты для каждого сервиса с помощью параметров --api.port <порт>.

При необходимости вы можете изменить сертификат веб-консоли KUMA на сертификат своей компании.

В начало

[Topic 269330]

Подготовка контрольной машины

Чтобы подготовить контрольную машину для установки KUMA:

- Убедитесь, что соблюдены аппаратные и программные требования, а также требования к установке программы.

- Сгенерируйте SSH-ключ для аутентификации на SSH-серверах целевых машин, выполнив следующую команду:

sudo ssh-keygen -f /root/.ssh/id_rsa -N "" -C kuma-ansible-installer

Если на контрольной машине заблокирован доступ root по SSH, сгенерируйте SSH-ключ для аутентификации на SSH-серверах целевых машин с помощью пользователя из группы sudo:

Если у пользователя нет прав sudo, добавьте пользователя в группу sudo:

usermod -aG sudo user

ssh-keygen -f /home/<имя пользователя из группы sudo>/.ssh/id_rsa -N "" -C kuma-ansible-installer

В результате ключ будет сгенерирован и сохранен в домашней директории пользователя. Вам следует указать полный путь к ключу в файле инвентаря в значении параметра ansible_ssh_private_key_file, чтобы ключ был доступен при установке.

- Убедитесь, что контрольная машина имеет сетевой доступ ко всем целевым машинам по имени хоста и скопируйте SSH-ключ на каждую целевую машину, выполнив следующую команду:

sudo ssh-copy-id -i /root/.ssh/id_rsa root@<имя хоста контрольной машины>

Если на контрольной машине заблокирован доступ root по SSH и вы хотите использовать ключ SSH из домашней директории пользователя из группы sudo, убедитесь, что контрольная машина имеет сетевой доступ ко всем целевым машинам по имени хоста и скопируйте SSH-ключ на каждую целевую машину, выполнив следующую команду:

ssh-copy-id -i /home/<имя пользователя из группы sudo>/.ssh/id_rsa <имя пользователя из группы sudo>@<имя хоста контрольной машины>

- Скопируйте архив с установщиком

kuma-ansible-installer-ha-<номер версии>.tar.gz на контрольную машину и распакуйте его с помощью следующей команды:sudo tar -xpf kuma-ansible-installer-ha-<номер версии>.tar.gz

Контрольная машина готова для установки KUMA.

В начало

[Topic 269332]

Подготовка целевой машины

Чтобы подготовить целевую машину для установки компонентов KUMA:

- Убедитесь, что соблюдены аппаратные и программные требования, а также требования к установке.

- Установите имя хоста. Мы рекомендуем указывать FQDN. Например: kuma1.example.com.

Не следует изменять имя хоста KUMA после установки: это приведет к невозможности проверки подлинности сертификатов и нарушит сетевое взаимодействие между компонентами программы.

- Зарегистрируйте целевую машину в DNS-зоне вашей организации для преобразования имен хостов в IP-адреса.

Вариант с использованием файла /etc/hosts не применим для развертывания Ядра в Kubernetes.

- Чтобы получить имя хоста, которое потребуется указать при установке KUMA, выполните следующую команду и запишите результат:

hostname -f

Целевая машина должна быть доступна по этому имени для контрольной машины.

Целевая машина готова для установки компонентов KUMA.

В начало

[Topic 269334]

Подготовка файла инвентаря k0s.inventory.yml

Развернуть всё | Свернуть всё

Чтобы создать файл инвентаря k0s.inventory.yml:

- Перейдите в директорию установщика KUMA, выполнив следующую команду:

cd kuma-ansible-installer-ha

- Скопируйте шаблон k0s.inventory.yml.template и создайте файл инвентаря с именем k0s.inventory.yml:

cp k0s.inventory.yml.template k0s.inventory.yml

- Отредактируйте параметры файла инвентаря k0s.inventory.yml.

Пример файла инвентаря для демонстрационной установки с Ядром в Kubernetes

all:

vars:

ansible_connection: ssh

ansible_user: root

deploy_to_k8s: true

need_transfer: false

generate_etc_hosts: false

deploy_example_services: true

kuma:

children:

kuma_core:

hosts:

kuma.example.com:

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma.example.com:

kuma_correlator:

hosts:

kuma.example.com:

kuma_storage:

hosts:

kuma.example.com:

shard: 1

replica: 1

keeper: 1

kuma_k0s:

children:

kuma_control_plane_master_worker:

hosts:

kuma-cpw.example.com:

ansible_host: 10.0.2.11

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

Для демонстрационной установки следует указать deploy_example_services: true - KUMA развернет демонстрационные сервисы на указанных хостах и назначит роль шарда, реплики и кипера указанному хосту, настраивать эти роли для демонстрационной установки в веб-интерфейсе KUMA не нужно.

Пример файла инвентаря для распределенной установки в отказоустойчивой конфигурации с 3 контроллерами, 2 рабочими узлами и 1 балансировщиком

all:

vars:

ansible_connection: ssh

ansible_user: root

deploy_to_k8s: true

need_transfer: false

generate_etc_hosts: false

deploy_example_services: false

kuma:

children:

kuma_core:

hosts:

kuma-core.example.com:

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma-collector.example.com:

kuma_correlator:

hosts:

kuma-correlator.example.com:

kuma_storage:

hosts:

kuma-storage-cluster1.server1.example.com

kuma-storage-cluster1.server2.example.com

kuma-storage-cluster1.server3.example.com

kuma-storage-cluster1.server4.example.com

kuma-storage-cluster1.server5.example.com

kuma-storage-cluster1.server6.example.com

kuma-storage-cluster1.server7.example.com

kuma_k0s:

children:

kuma_lb:

hosts:

kuma-lb.example.com:

kuma_managed_lb: true

kuma_control_plane_master:

hosts:

kuma_cpm.example.com:

ansible_host: 10.0.1.10

kuma_control_plane_master_worker:

kuma_control_plane:

hosts:

kuma_cp2.example.com:

ansible_host: 10.0.1.11

kuma_cp3.example.com:

ansible_host: 10.0.1.12

kuma_control_plane_worker:

kuma_worker:

hosts:

kuma-w1.example.com:

ansible_host: 10.0.2.11

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

kuma-w2.example.com:

ansible_host: 10.0.2.12

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

Для такой конфигурации следует указать параметры need_transfer: false, deploy_example_services: false, в разделе kuma_storage перечислить серверы для кластера хранения. Роли шарда, реплики и кипера вы сможете назначить указанным в инвентаре серверам в веб-интерфейсе KUMA после завершения установки.

Пример файла инвентаря для переноса Ядра в кластер Kubernetes из распределенной установки для обеспечения отказоустойчивости

all:

vars:

ansible_connection: ssh

ansible_user: root

deploy_to_k8s: true

need_transfer: true

generate_etc_hosts: false

deploy_example_services: false

kuma:

children:

kuma_core:

hosts:

kuma-core.example.com:

mongo_log_archives_number: 14

mongo_log_frequency_rotation: daily

mongo_log_file_size: 1G

kuma_collector:

hosts:

kuma-collector.example.com:

kuma_correlator:

hosts:

kuma-correlator.example.com:

kuma_storage:

hosts:

kuma-storage-cluster1.server1.example.com

kuma-storage-cluster1.server2.example.com

kuma-storage-cluster1.server3.example.com

kuma-storage-cluster1.server4.example.com

kuma-storage-cluster1.server5.example.com

kuma-storage-cluster1.server6.example.com

kuma-storage-cluster1.server7.example.com

kuma_k0s:

children:

kuma_lb:

hosts:

kuma-lb.example.com:

kuma_managed_lb: true

kuma_control_plane_master:

hosts:

kuma_cpm.example.com:

ansible_host: 10.0.1.10

kuma_control_plane_master_worker:

kuma_control_plane:

hosts:

kuma_cp2.example.com:

ansible_host: 10.0.1.11

kuma_cp3.example.com:

ansible_host: 10.0.1.12

kuma_control_plane_worker:

kuma_worker:

hosts:

kuma-w1.example.com:

ansible_host: 10.0.2.11

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

kuma-w2.example.com:

ansible_host: 10.0.2.12

extra_args: "--labels=kaspersky.com/kuma-core=true,kaspersky.com/kuma-ingress=true,node.longhorn.io/create-default-disk=true"

В файле инвентаря k0s.inventory.yml в разделах kuma_core, kuma_ collector, kuma_correlator, kuma_storage укажите те же хосты, которые использовались в файле distributed.inventory.yml при обновлении KUMA с версии 2.1.3 до версии 3.0.3, и затем до версии 3.2, или при новой установке программы. В файле инвентаря k0s.inventory.yml необходимо указать параметры deploy_to_k8s: true, need_transfer:true, deploy_example_services: false.